8 Minuty

Deep Web to część sieci, o której wiele osób słyszało, ale niewielu naprawdę ją rozumie. Nie chodzi tu wyłącznie o sensacyjne opowieści o nielegalnych rynkach — w głębi internetu kryją się setki miliardów stron i baz danych, które służą do badań naukowych, pracy w korporacjach czy przechowywania prywatnych kont. Ten artykuł wyjaśnia, czym jest Deep Web, jak technicznie działa, jakie niesie korzyści i zagrożenia oraz jak zachować bezpieczeństwo podczas korzystania z zasobów poza powierzchnią indeksowaną przez wyszukiwarki.

Co to jest Deep Web i czym różni się od Dark Web?

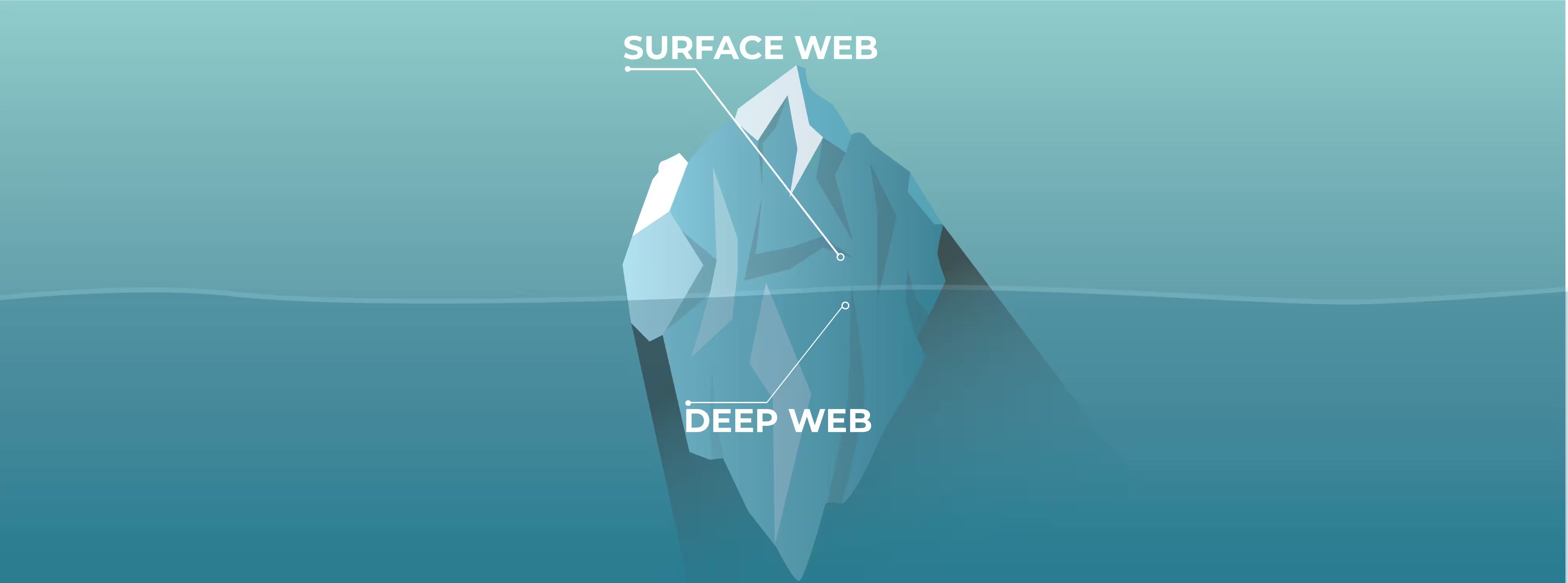

Termin "Deep Web" odnosi się do części internetu, której nie indeksują popularne wyszukiwarki, takie jak Google, Bing czy Yahoo. To zbiór treści niedostępnych dla standardowych robotów indeksujących: strony z wymaganym logowaniem, bazy danych generujące treść dynamicznie, repozytoria naukowe za paywallem, prywatne intranety firmowe czy archiwa medyczne. Większość tego, co nazywa się Deep Web, jest całkowicie legalna i ma uzasadnione zastosowania — od przechowywania wyników badań po systemy bankowe.

W obrębie Deep Web istnieje mniejszy, wyraźnie oddzielony obszar zwany Dark Web. Dark Web to ukryte usługi dostępne zwykle tylko przez specjalne oprogramowanie (np. przeglądarkę Tor) i wykorzystujące adresy .onion. To właśnie tam często koncentrują się treści anonimowe, które mogą obejmować zarówno narzędzia dla dysydentów i dziennikarzy, jak i rynki czy fora związane z działalnością przestępczą. Z punktu widzenia technicznego dark web jest podrzbiorem deep web — kluczowa różnica leży w stopniu ukrycia i konieczności stosowania specjalnych protokołów.

Jak technicznie działa Deep Web?

Na pierwszy rzut oka internet wydaje się być jedną wielką, łatwo przeszukiwalną przestrzenią. W praktyce jednak większość zasobów jest "pod powierzchnią". Dlaczego? Ponieważ wyszukiwarki działają dzięki robotom indeksującym, które skanują statyczne strony i podążają za linkami. Jeżeli materiały nie posiadają bezpośrednich linków, wymagają logowania, znajdują się za paywallem albo są generowane dynamicznie przez zapytania do bazy danych, roboty nie mają do nich dostępu.

Elementy technologiczne i powody braku indeksacji

- Treści dynamiczne: strony tworzone w locie przez zapytania do baz danych (np. wyniki wyszukiwania w katalogach) nie mają stałych adresów URL do indeksowania.

- Autoryzacja i paywalle: systemy z dostępem ograniczonym (logowanie, subskrypcje) celowo blokują botom wejście.

- Pliki i bazy: dokumenty w repozytoriach, archiwa medyczne czy firmowe bazy danych nie są linkowane ze strony publicznej.

- Pliki konfiguracyjne i roboty: instrukcje w robots.txt oraz meta-tagach noindex wyłączają fragmenty serwisu z indeksowania.

.avif)

Dostęp do niektórych części Deep Web odbywa się przy użyciu standardowych narzędzi — wystarczy znać bezpośredni adres URL i posiadać hasło. Dostęp do warstwy Dark Web wymaga często konfiguracji specjalnego oprogramowania. Najbardziej znanym mechanizmem jest Tor (The Onion Router) — system routingu cebulkowego, który przesyła ruch przez szereg zaszyfrowanych węzłów, utrudniając ustalenie źródła i celu połączenia.

W warstwie technicznej anonymity-onion polega na warstwowej szyfrowanej transmisji: każdy węzeł odczytuje jedynie fragment ścieżki, co zmniejsza możliwość korelacji ruchu. To działa dobrze dla prywatności, ale stwarza też pole do nadużyć. Dodatkowo istnieją alternatywne sieci i protokoły ukrytych usług (np. I2P, Freenet), które też tworzą fragmenty Deep Web o specyficznych zastosowaniach.

Zastosowania i korzyści Deep Web

Choć w popularnym dyskursie Deep Web często jest przedstawiany negatywnie, jego rola w codziennej pracy instytucji naukowych, zdrowotnych czy biznesowych jest kluczowa. Oto najważniejsze zastosowania:

- Repozytoria akademickie i bazy danych: wiele publikacji naukowych, danych eksperymentalnych czy kwerend laboratoryjnych znajduje się za paywallem lub w zasobach uczelnianych niedostępnych dla wyszukiwarek.

- Systemy medyczne i dokumentacja pacjentów: poufne dane zdrowotne wymagają dostępu ograniczonego, co naturalnie umieszcza je w Deep Web.

- Intranety korporacyjne i narzędzia biznesowe: aplikacje wewnętrzne, portale pracownicze czy systemy ERP są zaprojektowane, by być niewidoczne publicznie.

- Przechowywanie danych badawczych: laboratoria i instytucje finansują przechowywanie danych eksperymentalnych w zasobach ograniczonych.

- Przestrzeń dla wolnej ekspresji: w krajach o restrykcyjnym dostępie do informacji ukryte kanały mogą pozwalać na bezpieczną komunikację dysydentów, dziennikarzy i whistleblowerów.

Korzyści wynikają z prywatności i kontroli dostępu: administracja nad tym, kto widzi określone dane, jest nierzadko krytyczna dla poufności badań, ochrony danych osobowych i utrzymania konkurencyjności przedsiębiorstw. W nauce dostęp do nieindeksowanych baz może przyspieszać odkrycia, gdyż badacze sięgają do surowych danych i specjalistycznych repozytoriów, które nie mają sensu publikować na otwartej stronie.

Ryzyka i ograniczenia

Równocześnie Deep Web wiąże się z konkretnymi zagrożeniami. Część z nich wynika z samej natury braku nadzoru, część z możliwości użycia anonimowości do działań przestępczych.

- Przestępcza aktywność: chociaż większość Deep Web jest legalna, dark web — jego część — bywa wykorzystywany do handlu narkotykami, bronią, usług hakerskich czy handlu danymi osobowymi.

- Brak regulacji i nadzoru: treści znajdujące się poza indeksacją bywają trudne do monitorowania dla organów ścigania i służb bezpieczeństwa.

- Zagrożenia dla prywatności: ironicznie, anonimowość może służyć zarówno ochronie prywatności, jak i działaniom, które tę prywatność naruszają (np. sprzedaż wykradzionych danych osobowych).

- Ryzyko malware: strony ukryte lub nieindeksowane często nie są moderowane — użytkownicy mogą natrafić na złośliwe oprogramowanie, oszustwa phishingowe i inne cyberzagrożenia.

- Trudności w dostępie do informacji: brak indeksacji oznacza, że bez odpowiednich odnośników lub wiedzy trudno trafić na wartościowe zasoby.

W kontekście bezpieczeństwa narodowego i cyberbezpieczeństwa szczególnie istotne są tzw. "blind spoty" — fragmenty infrastruktury IT organizacji, które nie są monitorowane przez standardowe narzędzia. Mogą one stać się celem ataków lub miejscem przechowywania wyciekających danych.

Expert Insight

"Deep Web to narzędzie o dwóch obliczach. Dla badaczy i osób potrzebujących prywatności — niezastąpione. Dla organów ścigania i specjalistów ds. bezpieczeństwa — wyzwanie do zrównoważonego nadzoru, który nie narusza praw obywateli" — mówi dr Anna Kowalska, ekspertka ds. cyberbezpieczeństwa i badaczka prywatności cyfrowej. "W praktyce chodzi o budowanie mechanizmów, które chronią wrażliwe dane, jednocześnie ograniczając możliwość ich wykorzystywania do przestępstw. To wymaga współpracy między nauką, sektorem prywatnym i ustawodawcami."

Jak bezpiecznie korzystać i jakie są dobre praktyki?

Jeśli musisz korzystać z zasobów spoza powierzchni web, warto zastosować kilka podstawowych zasad bezpieczeństwa:

- Aktualizuj oprogramowanie i korzystaj z dobrego antywirusa — to minimalizuje ryzyko złośliwego oprogramowania.

- Uważaj na źródła — weryfikuj, czy dany serwis lub plik pochodzi z zaufanego repozytorium.

- Stosuj uwierzytelnianie wieloskładnikowe (MFA) tam, gdzie to możliwe.

- Jeśli używasz narzędzi anonimizujących (np. Tor), ucz się ich konfiguracji i ograniczeń — nie jest to magiczne rozwiązanie gwarantujące pełne bezpieczeństwo.

- Rozważ stosowanie VPN w zestawieniu z innymi narzędziami prywatności, pamiętając o kompromisach między prędkością a ochroną danych.

Pamiętaj też o etyce: korzystanie z zasobów, do których nie posiadasz uprawnień, jest nielegalne i może prowadzić do poważnych konsekwencji. Dostęp do baz danych nietraktowanych jako publiczne powinien odbywać się w ramach regulaminów i umów licencyjnych.

Przyszłość, regulacje i perspektywy naukowe

W miarę jak gospodarka cyfrowa rozszerza się i ilość danych rośnie, rola Deep Web w nauce, medycynie i biznesie będzie rosła. Już dziś wiele projektów badawczych wymaga dostępu do dużych, niepublicznych zbiorów danych: genomiki, dane telemetrii z misji naukowych, badania epidemiologiczne. Odpowiednie zarządzanie tymi zasobami — tak, by były użyteczne, a jednocześnie bezpieczne — to wyzwanie zarówno techniczne, jak i prawne.

Na poziomie regulacyjnym obserwujemy coraz większe zainteresowanie tworzeniem zasad interoperacyjności i standardów ochrony danych, które pozwolą na wymianę zasobów badawczych bez utraty kontroli nad prywatnością. Technologie takie jak homomorficzne szyfrowanie, prywatne zapytania do baz danych czy mechanizmy audytu kryptograficznego mogą w przyszłości zmniejszyć potrzebę fizycznego udostępniania wrażliwych danych, zachowując jednocześnie ich użyteczność dla nauki.

W obszarze bezpieczeństwa rosną też możliwości wykrywania nadużyć dzięki zaawansowanej analizie ruchu sieciowego, machine learning i współpracy międzynarodowej służb. Równowaga między prywatnością a bezpieczeństwem pozostaje kluczowa.

Wnioski

Deep Web nie jest jednolitym zagrożeniem — to raczej zbiór technologii i praktyk, które odpowiadają na realne potrzeby prywatności, bezpieczeństwa i specjalistycznego dostępu do informacji. Jego istnienie jest niezbędne dla funkcjonowania systemów naukowych, medycznych i korporacyjnych. Jednocześnie część Deep Web, czyli Dark Web, stwarza wyzwania wymagające odpowiednich regulacji i narzędzi śledczych. Dla użytkowników najważniejsze są świadomość, ostrożność i przestrzeganie zasad bezpieczeństwa oraz prawa przy korzystaniu z zasobów poza powierzchnią indeksowaną przez wyszukiwarki.

Zostaw komentarz