10 Minuty

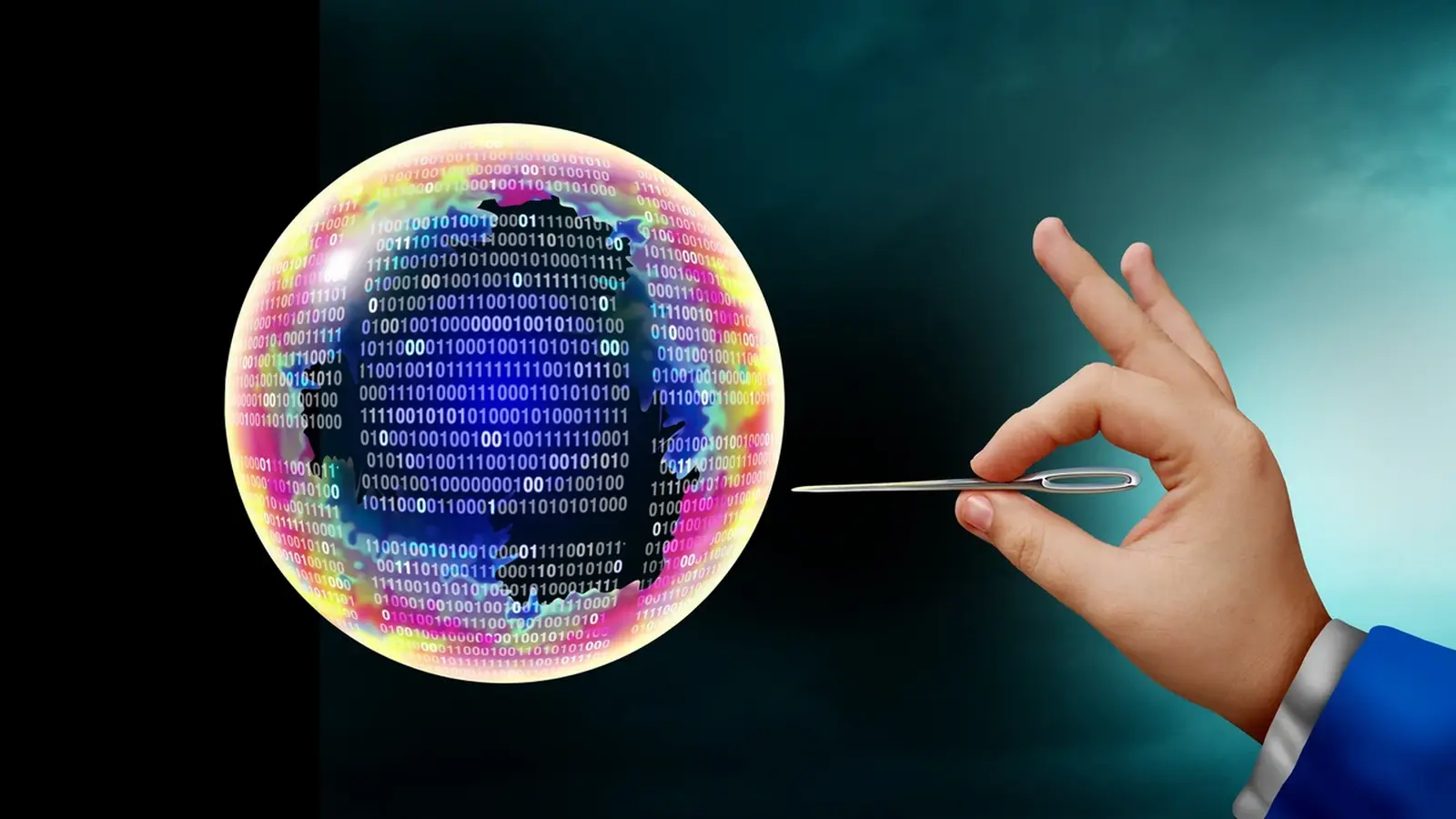

Wiele osób w branży technologicznej przyznaje wprost: jesteśmy w bańce AI. Kłopot w tym, że każdy widzi inną kreskę wykresu — jedni przewidują spektakularne pęknięcie, inni mówią o naturalnej korekcie przed długoletnim okresem rozwoju. W artykule przyjrzymy się, co naprawdę napędza ten boom, kto jest narażony na stratę oraz jakie naukowe i techniczne pytania kryją się za finansowymi nagłówkami.

Czym jest „bańka AI” i dlaczego ten termin wrócił do debat

Pojęcie "bańki" w kontekście technologii oznacza sytuację, w której oczekiwania rynkowe i wyceny firm rosną szybciej niż ich realne przychody lub potencjał ekonomiczny. W przypadku AI mamy do czynienia z połączeniem kilku elementów: gigantycznych inwestycji kapitałowych, obietnic transformacyjnych (sztuczna inteligencja ma zmienić pracę, edukację, opiekę zdrowotną), oraz trudności w szybkiej monetyzacji tych technologii.

W 2024 roku badanie cytowane w mediach sugerowało, że większość firm inwestujących w generatywne modele nie obserwuje jeszcze znaczącego zwrotu z tych działań. Nagłówki mówiły o 95% organizacji bez „zwrotu”, co wywołało spadki kursów spółek technologicznych. Wynik ten był zniuansowany, ale wystarczyło, by przyciągnąć uwagę inwestorów i komentatorów.

W międzyczasie liderzy branży sami przyznają, że panuje nadmierne podekscytowanie. Niektórzy szefowie firm technologicznych porównują obecny okres do dot-comowej euforii z końca lat 90., kiedy prosty pomysł na internet skończył się licznymi bankructwami, lecz też zrodził trwałe innowacje. Takie analogie pomagają zrozumieć, że bańka nie musi oznaczać, że technologia jest fałszywa — może raczej wskazywać, że rynkowe oczekiwania przewyższają realne tempo i koszty wdrożeń.

Co napędza nadmuch — pieniądze, centra danych i dostęp do mocy obliczeniowej

Najbardziej namacalnym symptonem boomu są astronomiczne inwestycje i plany budowy centrów danych. Firmy prywatne i publiczne przeznaczają setki miliardów dolarów na rozbudowę infrastruktury obliczeniowej: serwerownie z setkami tysięcy GPU, sieci światłowodowe i systemy chłodzenia energochłonnych klastrów. Niektóre deklaracje wydają się niemal futurystyczne — mowa o setkach gigawatów mocy obliczeniowej, porównywalnych do zapotrzebowania na energię całych państw.

Dlaczego to takie ważne? Nowoczesne modele językowe i multimodalne są ekstremalnie zasobożerne. Trening jednego przełomowego modelu może wymagać milionów godzin GPU, gigawatów mocy i układów chłodzenia, a to przekłada się na koszty liczone w miliardach dolarów. W rezultacie spółki, które nie mają dostępu do ogromnej mocy obliczeniowej, ryzykują pozostaniem w tyle.

Wąskie gardła: GPU i racjonowanie mocy

- Dystrybucja GPU: dostawcy chipów często priorytetyzują największych klientów, co utrudnia startupom zdobycie wystarczających zasobów.

- Długoterminowe zobowiązania: firmy podpisują kontrakty na wiele lat, blokując kapitał na infrastrukturę zanim pojawią się stałe przychody.

- Ceny energii i wydajność chłodzenia: centra danych stają się coraz bardziej energochłonne, co rodzi pytania o zrównoważony rozwój i lokalizację inwestycji.

Takie czynniki sprawiają, że nawet gdy technologia rzeczywiście działa, koszty wczesnego wejścia mogą przewyższać możliwości finansowe mniejszych graczy. To z kolei sprzyja koncentracji mocy w rękach kilku gigantów, co dodatkowo podgrzewa dyskusję o monopolizacji i etycznym wykorzystaniu AI.

Kto mówi, że to bańka — i komu zależy na tej narracji?

W debacie o bańce bardzo często słychać głosy z najwyższych szczebli branży: od założycieli startupów po szefów wielkich firm technologicznych. Każdy z tych głosów ma swoje tło i interesy. Niektórzy ostrzegają przed nadmiernym entuzjazmem, inni używają retoryki „bańki” jako narzędzia konkurencyjnego — wskazując na przesadne decyzje rywali i jednocześnie podkreślając stabilność własnego modelu biznesowego.

Wielu liderów przypomina, że w poprzednich falach inwestycji infrastrukturalnych — takich jak budowa sieci światłowodowych czy centrów danych — część firm upadła, ale kluczowa infrastruktura przetrwała i umożliwiła kolejne pokolenia usług. To stara, ale trafna uwaga: destrukcyjna selekcja może wyeliminować słabe projekty, jednocześnie zostawiając te, które potrafią przekształcić inwestycje w realne produkty i przychody.

W praktyce ton dyskusji zależy od pozycji rozmówcy. Firmy z dużymi rezerwami gotówkowymi mogą postulować agresywne wydatki, argumentując, że kto nie inwestuje teraz, przegapi przyszłe dominujące platformy. Mniejsze podmioty zaś obawiają się, że załamanie wycen i dostępności kredytu uderzy w nie najbardziej. Różne diagnozy wskazują więc na jednoczesne prawdy: technologia może być transformacyjna, ale rynkowe nadwyżki kapitału i emocji są realne.

Jak bańka mogłaby pęknąć — mechanizmy i scenariusze ryzyka

Najbardziej bezpośredni mechanizm pęknięcia to przeważnie nagłe załamanie płynności: inwestorzy odwracają się od ryzykownych projektów, wyceny spadają, a firmy z dużymi zobowiązaniami dofinansowującymi inwestycje infrastrukturalne nie mają skąd spłacić długów. W praktyce to może wyglądać różnie:

- Start-upy ze zbyt optymistycznymi prognozami przychodów nie będą w stanie uzasadnić wieloletnich kontraktów z dostawcami sprzętu.

- Firmy, które stawiają wszystko na jedną kartę (np. na rozwój jednego modelu), mogą stracić dostęp do kluczowych partnerów technologicznych lub klientów.

- Jeżeli potencjalne przychody z AI okażą się znacznie niższe niż przewidywano, wielu inwestorów będzie zmuszonych do rewizji wycen i strategicznych wycofań.

Skala skutków zależy także od stopnia rozprzestrzenienia długów i powiązań między firmami. Jeżeli zobowiązania wobec dostawców chipów, operatorów centrów danych lub banków są skumulowane w kilku dużych graczach, upadłości mogą mieć efekt domina. Z drugiej strony, firmy zdywersyfikowane i generujące stabilne przepływy pieniężne są lepiej przygotowane na korektę rynkową.

Trzeba też pamiętać o czasie: rynek prywatny zwykle reaguje wolniej niż giełdy publiczne. Oznacza to, że bańka może utrzymywać się dłużej niż oczekujemy, a jej pęknięcie może być stopniowe — z serią lokalnych kryzysów zamiast jednego spektakularnego krachu.

Ekonomiczne liczby — kto ile pali i ile może stracić

Niektóre analizy i raporty rynkowe przedstawiają oszałamiające projekcje wydatków. Szacunki spółek i konsultantów mówią o bilionach dolarów w inwestycjach w infrastrukturę AI w perspektywie kilku lat. Porównania do historycznych nakładów, jak koszty dużych programów badawczych czy budowy narodowych sieci energetycznych, mają na celu pokazanie skali wyzwań.

W praktyce jednak wydatki nie są równomierne: największe firmy technologiczne mają potencjał, by wchłonąć koszty nieudanych projektów, podczas gdy mniejsze firmy i startupy, często finansowane dźwignią lub krótkoterminowymi rundami inwestycyjnymi, są bardziej narażone na bankructwo. W efekcie możliwe jest scenariusz, w którym rynek konsoliduje się: wygrani to te firmy, które przetrwają i zmonetyzują technologie, przejmując talenty i klientów po upadłych konkurentach.

Technologia vs. biznes — czy wydatki idą w parze z modelem finansowym?

Wiele z dzisiejszych dużych projektów AI opiera się na przekonaniu, że ogromne modele i centra danych przyniosą w przyszłości nieporównywalne korzyści. Jednak aby inwestycje były opłacalne, potrzebne są sposoby generowania przychodów przewyższających koszty utrzymania i rozwoju tych systemów. Subskrypcje i opłaty za dostęp to jeden ze sposobów, ale eksperci podkreślają, że model oparty wyłącznie na abonamentach może nie wystarczyć, jeśli nie towarzyszą mu nowe formy monetyzacji — np. integracja AI z procesami korporacyjnymi, licencjonowanie rozwiązań do zastosowań przemysłowych, czy usługi oparte na wysokomarżowych rozwiązaniach enterprise.

Otwiera się tu też kwestia etyczna i społeczna: jeżeli tylko kilka firm kontroluje kluczową infrastrukturę, to decyzje dotyczące rozwoju i wdrożenia AI mogą odbijać się szeroko na rynku pracy, prywatności i bezpieczeństwie. To sprawia, że analiza inwestycyjna nie powinna ograniczać się do prognozy przychodów — musi uwzględniać również ryzyka regulacyjne, społeczne i technologiczne.

Badania, nauka i przyszłe kierunki — co jeszcze trzeba odkryć?

W perspektywie naukowej kluczowe pytania dotyczą kierunku rozwoju sztucznej inteligencji: czy dalsze postępy będą opierać się na skalowaniu obecnych architektur (więcej parametrów, więcej danych, więcej mocy obliczeniowej), czy też konieczne będą nowe przełomy teoretyczne, algorytmiczne i sprzętowe? Obie drogi mają swoje implikacje.

Skalowanie oznacza dalszy wzrost zapotrzebowania na centra danych, energię i układy GPU/TPU — co z kolei napędza inwestycje i potencjalne ryzyko finansowe. Przełomy algorytmiczne mogłyby natomiast zmniejszyć koszt uzyskania tej samej wydajności, ale są mniej przewidywalne i trudniejsze do wycenienia z perspektywy inwestora szukającego krótkoterminowych wyników.

W obszarze badań warto zwrócić uwagę na kilka wymiarów:

- Efektywność energetyczna i architektury sprzętowe dedykowane do AI.

- Metody uczenia, które wymagają mniej danych lub potrafią uczyć się szybciej (np. uczenie przyrostowe, meta-learning).

- Integracja AI z systemami cyberfizycznymi — czyli zdolność modeli do rozumienia i oddziaływania z rzeczywistym światem.

- Bezpieczeństwo i interpretowalność modeli, zwłaszcza gdy wdraża się je w krytycznych zastosowaniach.

.avif)

Expert Insight

Dr Anna Kowalska, specjalistka ds. systemów rozproszonych i energetyki obliczeniowej, komentuje: «Obecne porównania do bańki dot-com mają sens, ale warto pamiętać o jednej różnicy — infrastruktura AI ma zastosowania gospodarcze, które już teraz przynoszą realne korzyści w optymalizacji procesów przemysłowych i analizie danych. To nie znaczy, że nie zabraknie ofiar; raczej, że skala restrukturyzacji może być większa. Inwestorzy powinni badać nie tylko potencjał technologiczny, ale i realne modele biznesowe tych projektów».

Profesor Marek Zieliński, badacz algorytmów efektywności energetycznej, dodaje: «Jeżeli nie zainwestujemy równolegle w nowe architektury chłodzenia i bardziej efektywne układy obliczeniowe, koszty energetyczne mogą stać się hamulcem rozwoju. To nie tylko problem finansowy, to kwestia odpowiedzialności klimatycznej».

Regulacje, etyka i rola państwa

W miarę jak rynkowe emocje rosną, rośnie również zainteresowanie regulatorów. Rządy i organy nadzorcze zaczynają analizować konsekwencje koncentracji mocy obliczeniowej, ryzyk związanych z bezpieczeństwem modeli oraz wpływu AI na zatrudnienie. Regulacje mogą mieć kilka celów: ochrona konsumentów, zabezpieczenie przed monopolizacją, ograniczenie ryzyk systemowych oraz zapewnienie, że publiczne interesy (np. prywatność obywateli) nie zostaną poświęcone dla szybkich zysków.

Regulatory mogą również odgrywać pozytywną rolę, wspierając długoterminowe badania i infrastrukturę jako publiczne dobro — na wzór dużych programów badawczych finansowanych w przeszłości. Taka strategia może zmniejszyć szok dla sektora prywatnego i pomóc przenieść część kosztów innowacji na szeroką wspólnotę, ale wymaga jasnej polityki i międzynarodowej współpracy.

Wnioski

Jesteśmy w unikalnym momencie: technologia AI wykazuje rzeczywisty potencjał transformacyjny, ale towarzyszy jej gwałtowny przypływ kapitału i ambicji, który łatwo może przerosnąć realistyczne horyzonty czasowe i modele przychodowe. Bańka może doprowadzić do konsolidacji rynku, szybkich upadków i silnych efektów ubocznych na mniejszych podmiotach. Jednocześnie, po okresie korekty, dobrze przygotowane projekty mają szansę przynieść długotrwałe korzyści społeczeństwu.

Dlatego warto patrzeć na ten czas nie tylko przez pryzmat strachu, ale też jako okazję do przemyślenia strategii inwestycyjnych, polityk regulacyjnych i priorytetów badawczych. W praktyce oznacza to większy nacisk na modele biznesowe, zrównoważoną infrastrukturę, przejrzystość finansową i interdyscyplinarne badania, które pomogą ocenić, które zakłady inwestycyjne mają realne szanse stać się fundamentem przyszłej gospodarki opartej na sztucznej inteligencji.

Zostaw komentarz