13 Minuty

Wstęp — od moralnego potępienia do technologicznej refleksji

W drugiej połowie 2023 roku polska sieć przeżyła jedną z bardziej burzliwych kampanii internetowych wobec twórcy treści — przypadek, który dziś warto analizować nie tylko jako medialny skandal, lecz także jako studium mechanizmów digitalnej narracji, algorytmicznej amplifikacji i słabości weryfikacji cyfrowych dowodów. Ta opowieść o Krzysztofie Gonciarzu — youtuberze o dużych zasięgach i progresywnym wizerunku — odsłania, jak łatwo niesprawdzone materiały i emocjonalne nagłówki zastępują rzetelne dochodzenie i jakie konsekwencje ma to dla ofiar rzeczywistych oraz fałszywie oskarżonych.

Dla technologicznych obserwatorów i specjalistów ds. bezpieczeństwa cyfrowego sprawa ta staje się też lekcją o tym, które narzędzia warto wdrażać w newsroomach, jak projektować systemy moderacji społecznościowych oraz jakie rozwiązania techniczne i procesowe mogą ograniczyć ryzyko dezinformacji. W artykule łączę rekonstrukcję wydarzeń z analizą technologiczną — opisuję mechanizmy, narzędzia i dobre praktyki związane z weryfikacją dowodów cyfrowych oraz omawiam implikacje rynkowe dla firm tworzących technologie weryfikacyjne, AI i platformy społecznościowe.

Chronologia i faktografia: jak zaczęła się fala oskarżeń

Pierwsze call‑outy i ich zasięg

Pod koniec września 2023 roku w mediach społecznościowych pojawiły się nagrania, w których modelka opisała rzekome niewłaściwe zachowania jednego z najbardziej rozpoznawalnych polskich youtuberów. Treści rozpowszechniły się błyskawicznie — opisy zachowań, screenshoty konwersacji i emocjonalne relacje zaczęły być cytowane przez portale, influencerów i użytkowników. W sieci uruchomiła się kaskada poinformowań, które w efekcie doprowadziły do szerokiego „scancelowania” — pozbawienia społecznego poparcia i wykluczenia z komercyjnych współprac.

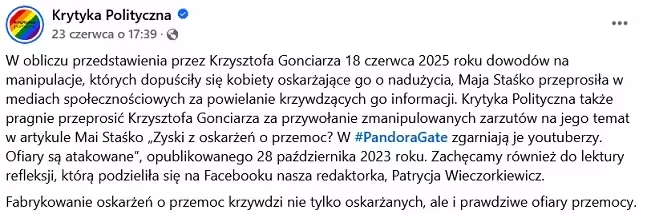

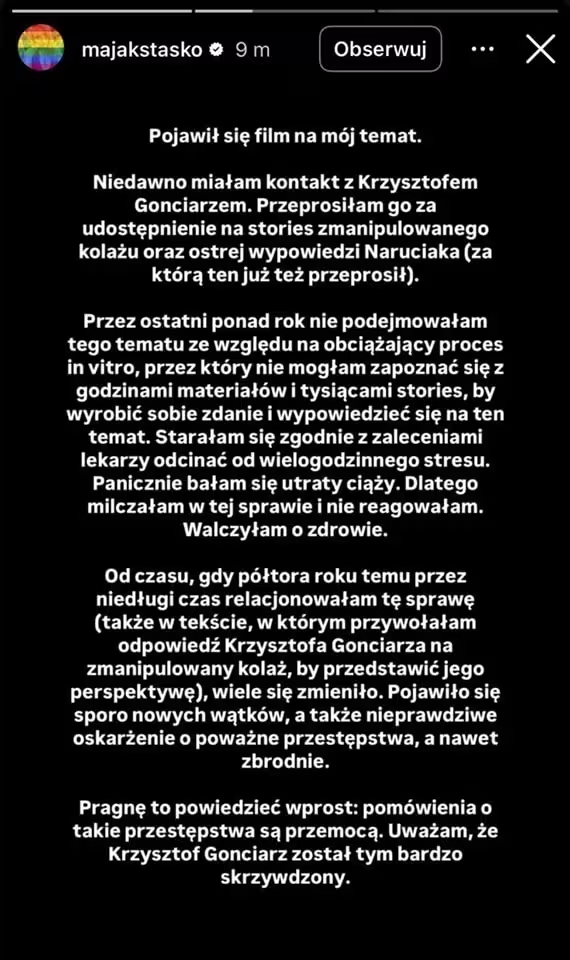

Rozwój sprawy — oskarżenia, odpowiedzi, milczenie i powroty

W kolejnych tygodniach pojawiły się dalsze relacje, skany ekranów i nagrania. W odpowiedzi oskarżany twórca wycofał się na jakiś czas z aktywności, by później opublikować własne nagrania wyjaśniające. W miarę upływu miesięcy ujawniły się jednak dowody wskazujące na manipulacje materiałów — spreparowane screenshoty, wyrwane z kontekstu wiadomości oraz nieścisłości w relacjach. To spowodowało falę przeprosin od niektórych mediów i influencerów, które wcześniej powieliły oskarżenia bez pełnej weryfikacji.

Algorytmy rekomendacji, virality i ekonomia uwagi

Jak systemy platform wpływają na tempo i zasięg oskarżeń

Platformy społecznościowe — YouTube, TikTok, Instagram — opierają swoje mechanizmy na algorytmach rekomendacji, które optymalizują zaangażowanie. Treści wywołujące silne emocje, negatywne narracje oraz kontrowersje osiągają szybciej duży zasięg, ponieważ algorytmy traktują reakcje (komentarze, udostępnienia, czas oglądania) jako sygnały wartości.

W praktyce oznacza to, że oskarżenia rozprzestrzeniają się znacznie szybciej niż ich weryfikacja. W systemach rekomendacyjnych nie ma naturalnej bariery „czasowej” pozwalającej na wprowadzenie procesu fact‑checking przed eskalacją tematu. Efekt — narracja przenika do mainstreamu zanim redakcje lub narzędzia do analizy dowodów zdążą przeprowadzić weryfikację.

Ekonomia klików a spadek etosu dziennikarskiego

Równolegle rynkowe presje — wyścig o kliknięcia, spadki budżetów redakcyjnych i rosnąca liczba zewnętrznych autorów — ograniczają możliwości przeprowadzenia rzetelnej weryfikacji. To tworzy lukę, którą wypełniają emocjonalne nagłówki i viralowe materiały. Z perspektywy technologicznej jest to też biznesowa szansa dla narzędzi do automatycznej weryfikacji fact‑check, ale też ostrzeżenie: bez zmian procesowych nawet najlepsze narzędzia mogą pozostać niedostatecznie wykorzystywane.

Manipulacja cyfrowa: screenshoty, metadata, deepfake — jak powstają „dowody”

Screeny i edycja kontekstu

Wiele pudełek z dowodami w omawianych sprawach to screenshoty komunikatorów i fragmenty rozmów. To jednocześnie format łatwy do przygotowania i trudny do natychmiastowej weryfikacji. Można zmienić treść, datę, a nawet styl graficzny wielu komunikatorów. Weryfikacja takiego materiału wymaga analizy metadanych, weryfikacji źródła pliku, porównania fragmentów konwersacji z oryginalnymi kopiiami oraz analizy kontekstu czasowego.

Metadane, EXIF i narzędzia do analizy

W praktyce technicznej kluczowe są metadane plików graficznych i wideo. Narzędzia takie jak ExifTool pozwalają odczytać informacje o dacie utworzenia pliku, urządzeniu, lokalizacji GPS (jeżeli zapisano) oraz o programach użytych do edycji. Jednak metadane także można fałszować. Stąd potrzeba stosowania wielowarstwowej weryfikacji: reverse image search (Google, TinEye), analiza error level (FotoForensics), badanie plików w oryginalnym konteście (np. archiwa chmurowe, backupy) oraz porównanie rozmów z zapisami serwerów, gdy są dostępne.

Deepfake i syntetyczne media

Choć w omawianej sprawie nie ma powszechnego dowodu deepfake, rosnąca dostępność narzędzi do generowania fałszywych wideo i audio powinna być sygnałem alarmowym. Modele generatywne i techniki edycji audio mogą tworzyć wiarygodne „dowody”, które będą wymagały specjalistycznej analizy forensycznej (np. badanie artefaktów kompresji, niezgodności fazowych, analizy spektralnej audio). Firmy z branży digital forensics oferują usługi analizy autentyczności nagrań, ale one bywają kosztowne i czasochłonne.

Technologie weryfikacji — przegląd narzędzi, funkcji i zastosowań

Poniżej krótka charakterystyka kategorii narzędzi przydatnych w weryfikacji materiałów cyfrowych, z porównaniem kluczowych funkcji, przewag i ograniczeń.

1. Narzędzia do analizy obrazu i wideo

- Funkcje: reverse image search, error level analysis (ELA), detekcja manipulacji pikseli, porównanie wersji pliku, analiza klatek wideo.

- Przykładowe zastosowania: wykrywanie edycji screenshotów, identyfikacja źródła obrazu, analiza oryginalności nagrań.

- Zalety: szybkie wskazanie podejrzanych zmian, darmowe lub niskokosztowe opcje.

- Ograniczenia: fałszywe pozytywy przy silnej kompresji, ograniczona skuteczność wobec zaawansowanych manipulacji.

2. Narzędzia do analizy metadanych i łańcucha dowodów (provenance)

- Funkcje: ekstrakcja EXIF, porównanie hashów plików, analiza dat i edycji, blockchainowe timestampring dla zabezpieczenia dowodów.

- Przykładowe zastosowania: ustalenie autentycznego czasu utworzenia pliku, potwierdzenie nienaruszalności materiału, tworzenie ścieżki audytu.

- Zalety: wysoka precyzja w przypadku dostępnych oryginalnych plików.

- Ograniczenia: metadane można edytować, blockchainowe rozwiązania wymagają przyjęcia standardu i infrastruktury.

3. Platformy do monitoringu i analizy sieciowej (social listening)

- Funkcje: śledzenie wzmianek, analiza sieci rozpowszechniania, identyfikacja węzłów dezinformacyjnych, szacowanie zasięgów.

- Przykładowe zastosowania: ocena, jak i gdzie rozprzestrzenia się narracja, wykrywanie botów i farm kont, identyfikacja kluczowych influencerów eskalujących temat.

- Zalety: pozwalają na strategiczne decyzje komunikacyjne i szybkie interwencje.

- Ograniczenia: koszt licencji, potrzeba dedykowanej analizy human‑in‑the‑loop.

4. Usługi digital forensics i analizy eksperckiej

- Funkcje: zaawansowana analiza plików, badanie sprzętowe, audyty łańcucha dowodów, opinie biegłych.

- Przykładowe zastosowania: sprawy prawne, weryfikacja wątpliwych dowodów do wykorzystania w sądzie.

- Zalety: wysoki poziom wiarygodności, raporty eksperckie.

- Ograniczenia: koszty, czas, wymóg przechowywania łańcucha dowodów.

Porównanie narzędzi — kiedy użyć czego?

W redakcyjnym lub korporacyjnym procesie weryfikacji rekomenduję wielowarstwowe podejście: na etapie wstępnym użyć narzędzi do natychmiastowej analizy obrazu i reverse search; następnie, gdy temat eskaluje, wdrożyć monitoring sieciowy i sprawdzić metadane; w końcu, jeśli materiał ma mieć skutki prawne lub reputacyjne, skierować sprawę do laboratorium digital forensics.

Dla przykładu:

- Szybkie sprawdzenie autentyczności screenshotu: reverse image search + ELA.

- Wątpliwe nagranie audio/video o dużej wadze: raport digital forensics + analiza spektralna.

- Kampania dezinformacyjna: social listening + analiza grafu rozprzestrzeniania.

Rola redakcji i procesu fact‑checking w epoce algorytmów

Procesy weryfikacyjne — jak newsroomy mogą chronić się przed błędem

Redakcje muszą zainwestować nie tylko w narzędzia, ale w proces. Nawet najlepsze oprogramowanie nie zastąpi procedur: jasnych standardów kontaktu z oskarżanymi, wieloetapowej weryfikacji dowodów, konsultacji z ekspertami ds. forensyki cyfrowej oraz wdrożenia praktyk „hold and verify” — czyli wstrzymania publikacji do czasu potwierdzenia krytycznych elementów.

Automatyzacja z ludzkim nadzorem — model human‑in‑the‑loop

Skalowanie fact‑checkingu wymaga automatyzacji (AI do wstępnego filtrowania, klasyfikacji treści i wykrywania manipulative patterns), ale decyzję o publikacji powinien podejmować zespół redakcyjny. Modele ML potrafią wykryć anomalie i sugerować poziom ryzyka, lecz często nie rozpoznają niuansów relacyjnych i kontekstowych, które mają kluczowe znaczenie w sprawach osobistych.

Rynek technologii weryfikacyjnych — popyt, produkty i model biznesowy

Afera Gonciarza uwidoczniła popyt na produkty z obszaru digital forensics, provenance i AI‑driven fact‑checking. Firmy oferujące te rozwiązania działają w kilku modelach: SaaS dla mediów i platform, konsultacje eksperckie dla prawników i firm PR oraz rozwiązania B2B integrujące API z systemami monitoringu mediów.

Z punktu widzenia rynku, kluczowe cechy, które decydują o wartości produktu to:

- szybkość analizy (time‑to‑insight),

- poziom pewności (scoring autentyczności),

- możliwość audytowalności (raporty i łańcuch dowodów),

- integracja z platformami social i newsroomowymi workflow.

Firmy, które zapewnią interoperacyjność (np. eksport wyników do systemów CMS, możliwość generowania raportów prawnych), zyskają przewagę konkurencyjną. Transparentne modele obliczania pewności i komunikaty o ograniczeniach narzędzia będą budować zaufanie klientów.

Use cases — zastosowania praktyczne i scenariusze

1) Redakcja otrzymuje screen rozmowy rzekomo kompromitującej znanego twórcę. Use case: wstępna analiza ELA + reverse image search → brak wyraźnych dowodów manipulacji → uruchomienie procesu kontaktu z oskarżanym oraz prośba o oryginalne pliki. Jeśli oskarżony odmawia, redakcja informuje o braku potwierdzenia zamiast publikować oskarżenie.

2) Agencja PR klienta doświadcza wiralowego ataku. Use case: social listening + identyfikacja węzłów dezinformacji → przygotowanie raportu z rekomendacjami działania (składanie sprzeciwów na platformach, publikacja kontrargumentów, eskalacja do digital forensics w przypadku spreparowanych dowodów).

3) Organizacja pozarządowa dokumentuje nadużycie i chce zabezpieczyć dowody przed zmanipulowaniem. Use case: natychmiastowe timestampring plików w blockchainie, eksport metadanych, kopia zapasowa w certyfikowanym archiwum.

Dlaczego większość przypadków nie trafia do prokuratury — i co to oznacza

Wielu call‑outów w social media nigdy nie dociera do instytucjonalnej weryfikacji ze względu na brak formalnych narzutów, pragnienie natychmiastowej publicznej odpowiedzi lub trudność w udokumentowaniu dowodów spełniających standardy prawne. To rozdzielenie między „sprawą social” a „sprawą formalną” zwiększa ryzyko błędów, gdyż społeczny wyrok często zapada zanim powstanie dokumentacja wystarczająca do formalnego dochodzenia.

Analiza przypadku Gonciarza: czego nauczyliśmy się z technologicznego punktu widzenia

1) Weryfikacja materiałów: fragmenty rozmów okazały się częściowo zmanipulowane lub wyrwane z kontekstu — przypomina to, że ocena pojedynczych screenshotów bez analizy metadanych i porównania z oryginałem jest ryzykowna.

2) Znaczenie zasięgu: youtuber, mając duże zasięgi, był w stanie zaprezentować szerszy kontekst i dowody wideo, co zrewanżowało pierwotne narracje. To pokazuje, że w warunkach nierówności zasięgów to strona z większymi kanałami komunikacji ma przewagę przy obronie reputacji.

3) Potrzeba standardów: brak jasnych standardów w redakcjach i w praktykach influencerów sprawił, że wiele publikacji powieliło treści bez wystarczającej weryfikacji — stąd konieczność wdrożenia check‑list i narzędzi wewnętrznych umożliwiających automatyczne flagowanie treści wymagających dodatkowej weryfikacji.

Równowaga między ochroną ofiar a ryzykiem fałszu — etyka i technologia

Istnieje napięcie: z jednej strony ruchy takie jak #MeToo przypomniały o konieczności słuchania ofiar i dążenia do sprawiedliwości; z drugiej — mechanizmy social mediowe i brak procedur mogą spowodować, że niewinne osoby zostaną publicznie zniszczone. Technologia nie jest neutralna: projektuje się mechanizmy rekomendacji, systemy flagowania treści i narzędzia do weryfikacji — wszystkie te elementy mają wpływ na to, które narracje zostaną wzmocnione. Dobre projekty technologiczne powinny zatem łączyć automatyzację z transparentnością i mechanizmami odwoławczymi.

Rekomendacje technologiczne i proceduralne

Dla mediów, platform i organizacji polecam wdrożenie poniższych praktyk:

- Wielowarstwowa weryfikacja dowodów: ELA, reverse search, Exif, digital forensics — w tej kolejności, z jasnym opisem ograniczeń każdego kroku.

- Human‑in‑the‑loop: automatyczna triage AI, ale decyzja o publikacji przez redakcję.

- Systemy provenance: stosowanie timestampingu i blockchainowych certyfikatów dla istotnych dowodów.

- Integracja narzędzi: API do płynnego eksportu wyników analizy do CMS i systemów prawnych.

- Edukacja użytkowników: komunikaty na temat prawdopodobieństwa manipulacji i instrukcje jak zgłaszać materiały do weryfikacji.

Przewagi i ograniczenia technologii — bilans

Technologie analityczne pozwalają na szybsze wykrycie anomalii i zmniejszają ryzyko powielania spreparowanych treści. Ich wdrożenie ma sens rynkowy: media i platformy są skłonne płacić za rozwiązania minimalizujące ryzyko reputacyjne. Równocześnie istnieją ograniczenia — od kosztów usług eksperckich po fakt, że najlepsze wyniki daje połączenie technologii i eksperckiej analizy. Rynek będzie więc się rozwijał w kierunku hybrydowych rozwiązań SaaS + usługi eksperckie.

Wnioski — czy to koniec dogmatu „wierzymy ofiarom"?

Sprawa Gonciarza pokazuje, że prosty dogmat „wierzymy ofiarom” w praktyce może prowadzić do błędów, jeśli nie towarzyszy mu weryfikacja. Nie neguję potrzeby słuchania osób mówiących o krzywdzie — wręcz przeciwnie — jednak w świecie cyfrowym powinna funkcjonować zasada: wierzyć i jednocześnie weryfikować. Zaufanie społeczne nie może zastępować procedur dowodowych. Technologie weryfikacyjne i procesowe standardy mogą pomóc wypracować równowagę między empatią a próbą ustalenia faktów.

Na co warto zwrócić uwagę w przyszłości — regulacje, narzędzia i odpowiedzialność platform

Przyszłość będzie wymagać trzech elementów: lepszych narzędzi forensycznych dostępnych dla mediów, jasnych procedur weryfikacyjnych w redakcjach oraz odpowiedzialności platform za transparentne mechanizmy moderacji i odwołań. Pojawia się też potencjał dla rozwiązań regulacyjnych — standardy dowodowe w przestrzeni cyfrowej, obowiązki szybkiej weryfikacji i narzędzia do archiwizacji dowodów.

Podsumowanie

Afera wokół Krzysztofa Gonciarza to nie tylko historia jednej osoby w internecie. To test całego ekosystemu informacyjnego — od użytkowników po media i technologie. Pokazuje, że w erze algorytmów i szybkiego rozpowszechniania narracji konieczne są lepsze narzędzia, procesy i kompetencje cyfrowe. Technologie weryfikacyjne, monitoring sieci i digital forensics mają dziś realną wartość rynkową i mogą ograniczyć szkody wywoływane przez niezweryfikowane oskarżenia. Ale samo narzędzie nie wystarczy — potrzebne są procedury i kultura weryfikacji.

Internet nie może stać się miejscem, gdzie każdy konflikt relacyjny natychmiast staje się politycznym sprawdzianem i narzędziem do niszczenia człowieka. Jednocześnie nie wolno marginalizować prawdziwych ofiar. Wyważenie tych dwóch racji będzie zadaniem dla technologów, prawników, redaktorów i całego społeczeństwa cyfrowego.

Checklista technologiczna dla redakcji i organizacji — szybkie kroki po otrzymaniu oskarżeń

1) Zachowaj oryginały plików i wykonaj kopie zapasowe. 2) Wykonaj reverse image search i ELA na otrzymanych grafikach. 3) Wyodrębnij metadane (ExifTool) i sprawdź daty, urządzenia, ewentualne ślady edycji. 4) Uruchom monitoring sieciowy, aby ocenić skalę i kierunek rozpowszechniania. 5) Skontaktuj się z osobą oskarżoną — dokumentuj próby kontaktu. 6) W razie dyskusyjnych dowodów zamów analizę ekspercką (digital forensics). 7) Jasno komunikuj ograniczenia weryfikacji, publikując stany pewności.

O autorze

Autor jest analitykiem technologicznym i konsultantem w obszarze bezpieczeństwa cyfrowego i weryfikacji treści. W tekście wykorzystano wiedzę z praktyki fact‑checkingu, digital forensics oraz analizę działania algorytmów rekomendacyjnych.

Źródło: spidersweb

Zostaw komentarz