5 Minuty

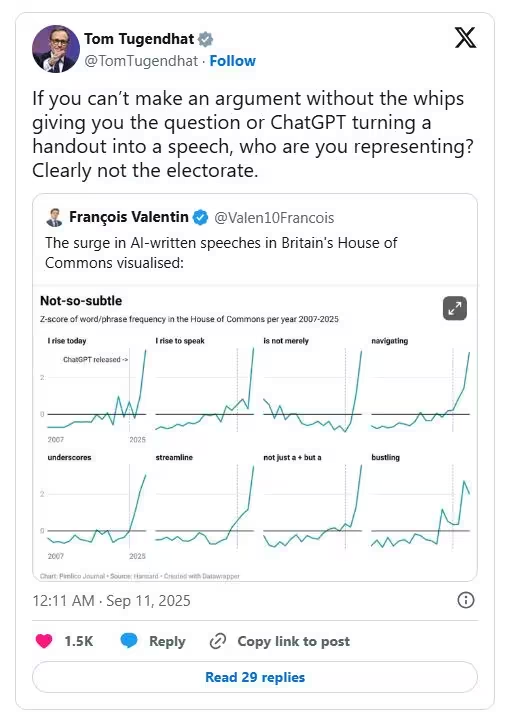

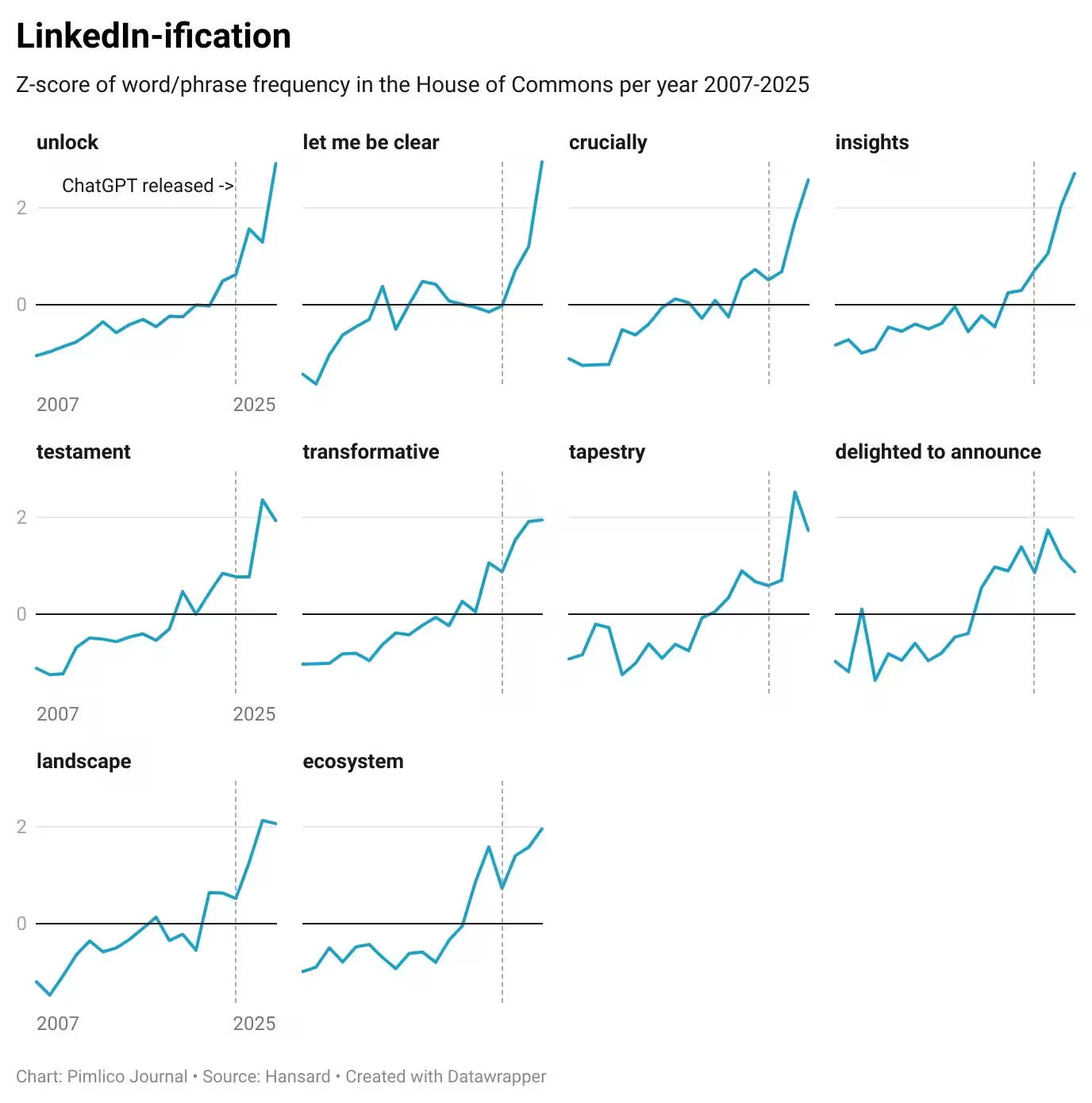

Wyobraź sobie sytuację, w której zamiast ludzkiego reprezentanta w parlamencie swoje przemówienia podpisuje algorytm wytrenowany na miliardach tekstów z internetu. To nie scenariusz science-fiction — w Zjednoczonym Królestwie pojawiają się twarde dowody, że styl wypowiedzi parlamentarzystów zaczyna nosić znamiona generatywnej sztucznej inteligencji. Analiza Pimlico Journal wykazała gwałtowny wzrost fraz typowych dla modelu ChatGPT — najgłośniej szumi fraza "I rise to speak", praktycznie nieobecna przez wieki w brytyjskim parlamencie, która w ostatnim okresie pojawiła się ponad trzykrotnie częściej. Statystyczny Z-score dla tej frazy osiągnął 3,60 — sygnał, że coś się zmieniło.

Jak rozpoznać „głos AI” w debacie parlamentarnej?

Wskaźniki językowe i konstrukcje typowe dla AI

Analiza wykazała wzrost użycia terminów takich jak underscores, streamline czy navigating — słów i fraz częstych w generowanych przez AI tekstach. Modele językowe mają swoje preferencje stylistyczne: skłonność do powtarzalnych konstrukcji (reguła trzech), preferowanych fraz przejściowych (not just... but...) i ogólnej „gładkości” wypowiedzi. Przykład Wendy Morton — konserwatywnej posłanki, która w krótkim wystąpieniu zastosowała regułę trzech aż 12 razy i użyła konstrukcji not just... but... wielokrotnie — posłużył jako case study rozpoznawania śladów AI w mowie parlamentarnej. Fragmenty typu "tears are a natural result of such a devastating awareness" brzmiały nienaturalnie, wręcz jak tłumaczenie maszynowe bez kontekstu emocjonalnego.

Od prywatnych skrzynek do mównicy — kto korzysta z AI?

Użycie ChatGPT przez posłów i urzędników

Zjawisko nie jest jednostkowe. Przykład laburzysty Mike'a Readera, który korzystał z ChatGPT, aby przygotowywać odpowiedzi na setki e-maili w trakcie podróży pociągiem, pokazuje praktyczny wymiar automatyzacji administracyjnej. Nawet gry w stylu "ChatGPT Bingo" służące do identyfikowania przemówień napisanych przez AI ujawniają, że wiele wypowiedzi parlamentarnych zaczyna się stereotypowo: "I rise to speak in support of...". Pierwszy publiczny przypadek zastosowania AI w brytyjskim parlamencie datuje się na grudzień 2022 r., gdy poseł Luke Evans wygłosił AI-napisane przemówienie w stylu Churchilla — on jednak otwarcie przyznał się do wykorzystania modelu.

Rządowe strategie i inwestycje — kierunek oficjalny

Inwestycje i pilotaże technologiczne

Rząd Wielkiej Brytanii oficjalnie inwestuje w rozwój AI — premier zapowiedział pakiet inwestycji wart 14 mld funtów oraz tworzenie tzw. AI Growth Zones. Dodatkowo wdrażane są programy pilotażowe, m.in. narzędzia typu Microsoft Copilot jako wsparcie dla posłów przy streszczeniach raportów i korespondencji. To pokazuje, że administracja traktuje AI jako element modernizacji biurokracji i komunikacji publicznej, chociaż eksperymentalne użycie narzędzi przez posłów bywa kontrowersyjne.

Polska perspektywa — PLLuM, deepfake i regulacje

Polskie rozwiązania i doświadczenia

W polskim kontekście Ministerstwo Cyfryzacji uruchomiło własny Polski Duży Model Językowy — PLLuM — testowany pilotażowo m.in. w Częstochowie do obsługi mieszkańców. Minister Krzysztof Gawkowski powołał zespół doradczy PL/AI, który ma przygotować rekomendacje dotyczące zastosowań AI w administracji. To bardziej systemowe podejście niż chaotyczne eksperymenty metodą prób i błędów. Jednak polskie doświadczenia też mają ciemne strony: w 2023 r. Platforma Obywatelska użyła głosu wygenerowanego przez AI do imitacji byłego premiera w kampanii wyborczej, co wywołało debatę o etyce deepfake'ów i transparentności kampanii.

Funkcje produktów AI — porównanie ChatGPT, PLLuM i Microsoft Copilot

Funkcje i przewagi rynkowe

- ChatGPT (OpenAI): uniwersalny model konwersacyjny, mocny w generowaniu tekstu, tworzeniu szkiców, stylizacji językowej i odpowiadaniu na pytania. Zalety: szybkość, elastyczność, duża baza treningowa. Wady: tendencyjność do amerykanizmów, brak lokalnych danych, ryzyko „kulturalnego dryfu”.

- PLLuM (polski model): projektowany z myślą o lokalnym języku i kontekście administracyjnym. Zalety: lepsze dopasowanie językowe, kontrola danych, zgodność z lokalnymi regulacjami. Wady: ograniczone zasoby treningowe, mniejsza wielozadaniowość w porównaniu do globalnych modeli.

- Microsoft Copilot: narzędzie integracyjne służące do automatycznego streszczania dokumentów i przyspieszania pracy biurowej. Zalety: integracja z pakietem Microsoft 365, funkcje wspomagające pracę zespołową. Wady: zależność od architektury dostawcy, wymagania bezpieczeństwa danych.

Zastosowania, przewagi i ryzyka

Use cases i rekomendacje

Zastosowania AI w polityce i administracji obejmują: automatyczne odpowiadanie na wiadomości wyborców, generowanie szkiców przemówień, streszczanie raportów, chatboty dla urzędów oraz wsparcie w analizie prawodawstwa. Główne zalety to efektywność, skalowalność i oszczędność czasu. Ryzyka to utrata tonu i autentyczności wypowiedzi, kulturowe zniekształcenie dyskursu, rozpowszechnianie deepfake'ów oraz brak przejrzystości wobec wyborców.

Co dalej — Sejm 2.0 czy demokracja 0.1?

Przykłady z Wielkiej Brytanii stawiają fundamentalne pytanie: czy chcemy, by algorytmy pisały za nas politykę i przemówienia? Jeśli AI może dobrać słowa kluczowe i poprawne formuły, ale bez emocjonalnego i etycznego zrozumienia tematu — czy nie osłabia to istoty debaty publicznej? Odpowiedź powinna łączyć pragmatyzm (funkcjonalne wykorzystanie narzędzi) z transparentnością i regulacjami. Polskie podejście — rozwój własnych modeli (PLLuM), prace doradcze PL/AI i pilotaże — daje szansę na zbudowanie ram, w których AI wspiera administrację i demokrację, zamiast je zastępować.

Podsumowanie: transparentność i edukacja jako klucz

AI w polityce to narzędzie o dużym potencjale oszczędności i optymalizacji pracy, ale także ryzykach związanych z etyką, manipulacją i utratą kulturowej tożsamości językowej. Najlepsza strategia to jawność stosowania narzędzi, edukacja polityków i urzędników oraz budowa lokalnych modeli i reguł prawnych, które zminimalizują negatywne efekty. Polska może wykorzystać doświadczenia Brytyjczyków, ucząc się na ich błędach i konstruując jasne standardy użycia AI — zanim algorytmy zaczną pisać naszą politykę za nas.

Źródło: spidersweb

Komentarze