5 Minuty

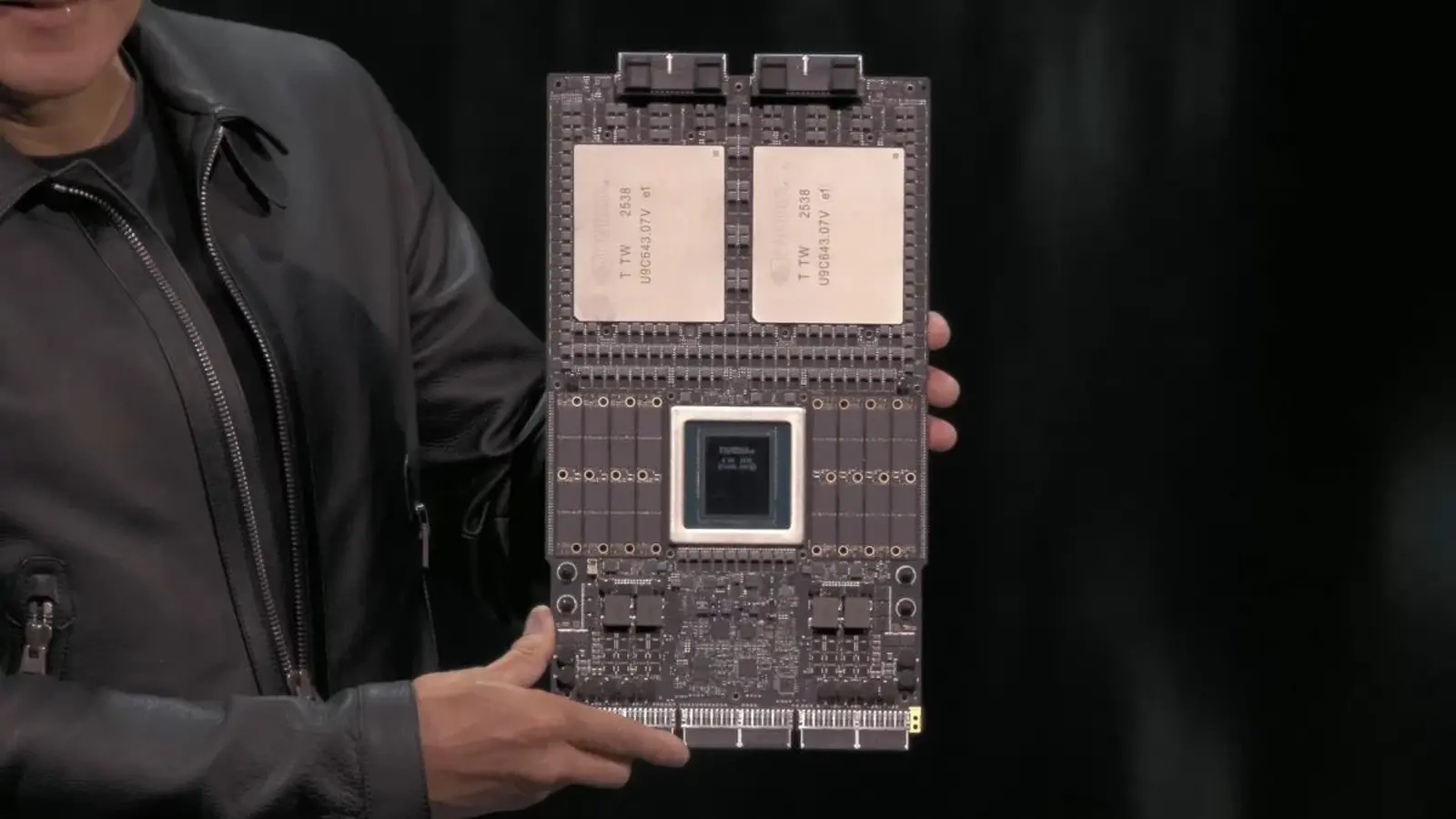

Samsung znajduje się obecnie na ostatniej prostej przed pokonaniem kluczowej przeszkody w rozwoju swojej następnej generacji pamięci HBM4. Firma przechodzi z etapu próbek i kwalifikacji do pełnoskalowej produkcji, która może zasilić nie tylko najnowszy procesor AI Nvidia Rubin, ale także inne zaawansowane akceleratory obliczeniowe.

Znaczenie HBM4 dla sztucznej inteligencji

Pamięć o wysokiej przepustowości (HBM) umożliwia pionowe układanie wielu warstw DRAM, co pozwala osiągnąć znacznie wyższą przepływność danych oraz niższe zużycie energii na bit w porównaniu do tradycyjnych modułów DDR czy LPDDR. W akceleratorach AI, gdzie konieczne jest błyskawiczne przetwarzanie ogromnych wag modeli i aktywacji, HBM staje się kluczowym elementem wydajnościowym. HBM4 to najnowszy krok milowy, wyznaczający nowy standard pod względem przepustowości i efektywności energetycznej, a producenci chipów ścigają się, by wdrożyć ją w swoich flagowych układach.

Po krótkim okresie pozostawania w tyle za konkurencją przy wcześniejszych generacjach HBM, obecny projekt HBM4 od Samsunga zapowiada powrót firmy do czołówki sektora półprzewodników. Z raportów branżowych wynika, że nowe układy mogą przewyższać pod względem parametrów produkty SK Hynix czy Micron, co byłoby istotnym sukcesem strategicznym, zważywszy na rosnącą rolę wydajności pamięci w nowoczesnych obciążeniach AI.

Proces zatwierdzenia, harmonogram i przyszłość

Zgodnie z doniesieniami agencji Bloomberg, Samsung przekazał próbki HBM4 Nvidia we wrześniu 2025 roku, a układy osiągnęły finalny etap kwalifikacji. Masowa produkcja ma ruszyć w lutym 2026 roku. Jeśli prognozowany harmonogram się utrzyma, Samsung może wkrótce stać się nie tylko kluczowym dostawcą dla Nvidii, ale również dla takich odbiorców, jak AMD czy Google, rozwijających własne rozwiązania AI.

Droga Samsunga do sukcesu nie była jednak łatwa. W poprzednich generacjach – HBM3 i HBM3E – napotkano problemy z wydajnością, które wymagały wdrożenia nowych projektów, by uzyskać aprobatę Nvidia. Część układów HBM3E była wykorzystywana tylko w wybranych akceleratorach Nvidia sprzedawanych na rynku chińskim, co podkreśla rygorystyczny charakter procesu kwalifikacyjnego. Teraz, gdy HBM4 doczekało się końcowego zatwierdzenia, można sądzić, że Samsung przezwyciężył wcześniejsze trudności techniczne.

Wyzwania i nowe szanse rynkowe

Czy HBM4 od Samsunga zrewolucjonizuje krajobraz pamięci półprzewodnikowej? Wiele na to wskazuje. Udane wprowadzenie masowej produkcji HBM4 umocniłoby pozycję firmy na rynku dotąd zdominowanym przez SK Hynix i Micron. Może to również przełożyć się na nowe zależności w globalnych łańcuchach dostaw, odpowiadających za kolejne generacje procesorów AI, takich jak Nvidia Rubin.

- Deweloperzy AI oraz partnerzy sprzętowi zyskają dostęp do większego wyboru wydajnych pamięci, co zwiększy konkurencję na rynku.

- Nowa technologia może pozwolić na szybsze trenowanie modeli i skuteczniejszą inferencję, odpowiadając na lawinowo rosnące potrzeby branży sztucznej inteligencji.

- Rozbudowa mocy produkcyjnych przez Samsunga stwarza szansę na zmniejszenie zależności rynkowych od dotychczasowych liderów.

Konkurencyjność i wpływ na sektor

Samsung HBM4, oferując znaczący wzrost przepustowości oraz efektywności energetycznej, stanowi odpowiedź na coraz bardziej wymagające zadania AI. Producenci tacy jak SK Hynix czy Micron muszą teraz podnieść poprzeczkę bądź zmierzyć się ze wzmacniającą się pozycją południowokoreańskiego giganta.

Dla całego ekosystemu technologicznego sukces tego projektu oznacza większą elastyczność oraz realną szansę uzyskania przewagi w wyścigu po lepsze wyniki obliczeniowe i kolejne przełomy w dziedzinie sztucznej inteligencji.

Przyszłość centrów danych i nowoczesnych akceleratorów AI

Luty 2026 roku może być kamieniem milowym w historii rozwoju pamięci – jeśli prognozy dotyczące produkcji masowej się potwierdzą, HBM4 trafi do centrów danych, które odpowiadają za obliczenia wspierające najnowsze modele AI, uczenie maszynowe oraz wymagające aplikacje analityczne.

Przyspieszenie transferów danych, ograniczenie zużycia energii i poprawa ogólnej wydajności systemów – to tylko niektóre korzyści, jakie może przynieść szerokie wdrożenie HBM4. Inwestycje firm takich jak Samsung w rozwój technologii pamięci wysokoprzepustowej to odpowiedź na oczekiwania rynku, który domaga się coraz lepszych parametrów przy zachowaniu konkurencyjnych kosztów.

Możliwe scenariusze dla branży AI

- Większa dostępność wydajnych modułów HBM4 podniesie poprzeczkę dla wszystkich graczy oraz zaostrzy walkę o dominację na rynku AI hardware.

- Dla finalnych użytkowników – w tym twórców rozwiązań AI i dużych operatorów centrów danych – pojawi się szansa na realizację złożonych projektów bez ograniczeń wynikających z barier sprzętowych.

- Kolejne generacje procesorów – jak Nvidia Rubin – zyskają dodatkowe atuty, jeśli zostaną połączone z pamięcią HBM4 najnowszej generacji.

Podsumowanie: Nowa era w pamięci dla AI

HBM4 od Samsunga to nie tylko ewolucja technologii, ale także potencjalna rewolucja w sektorze sztucznej inteligencji i rozwoju akceleratorów obliczeniowych. Dzięki zaawansowanym parametrom, szybszemu transferowi danych oraz niższemu zużyciu energii, pamięć ta może zadecydować o przewadze strategicznej globalnych graczy i otworzyć drogę do nowych rozwiązań w dziedzinie przetwarzania danych.

Z perspektywy rynku oraz deweloperów AI, luty 2026 r. zapowiada się jako moment, kiedy HBM4 przejdzie z fazy koncepcyjnej do rzeczywistej rewolucji w praktyce – stając się kluczowym elementem najnowocześniejszych centrów danych na świecie.

Źródło: sammobile

Zostaw komentarz