5 Minuty

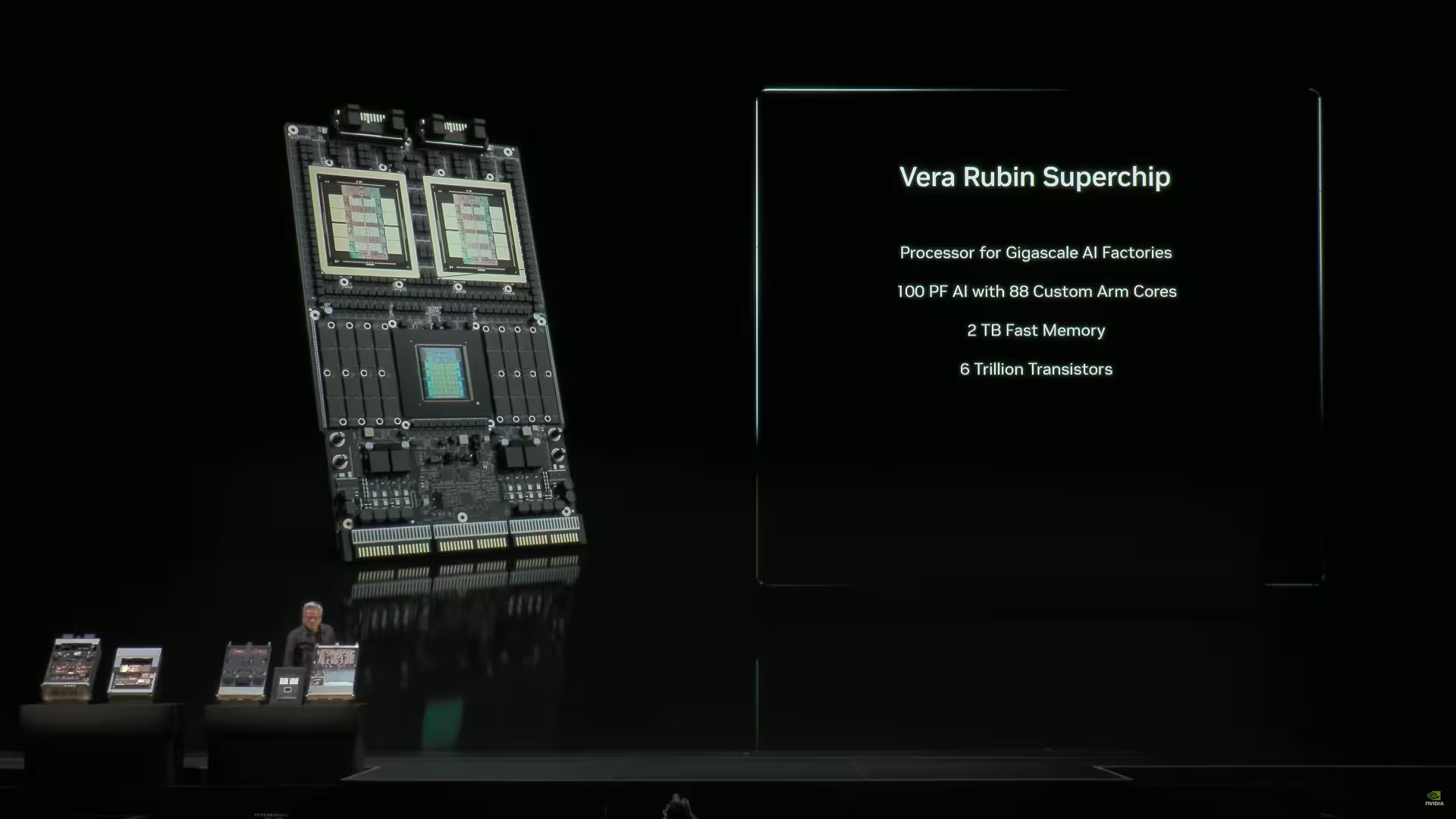

Podczas GTC 2025 firma NVIDIA po raz pierwszy zaprezentowała światu Superchip Vera Rubin — architekturę opartą na dwóch potężnych procesorach GPU, zintegrowanych z procesorem Vera CPU oraz dużą ilością pamięci LPDDR rozmieszczonej na krawędziach układu. Najnowsze doniesienia wskazują, że Rubin przeszedł z fazy testów laboratoryjnych do produkcji, a NVIDIA zapewniła sobie próbki pamięci HBM4 od każdego kluczowego producenta DRAM na świecie.

Od demonstracji do produkcji: istotne zmiany w procesie

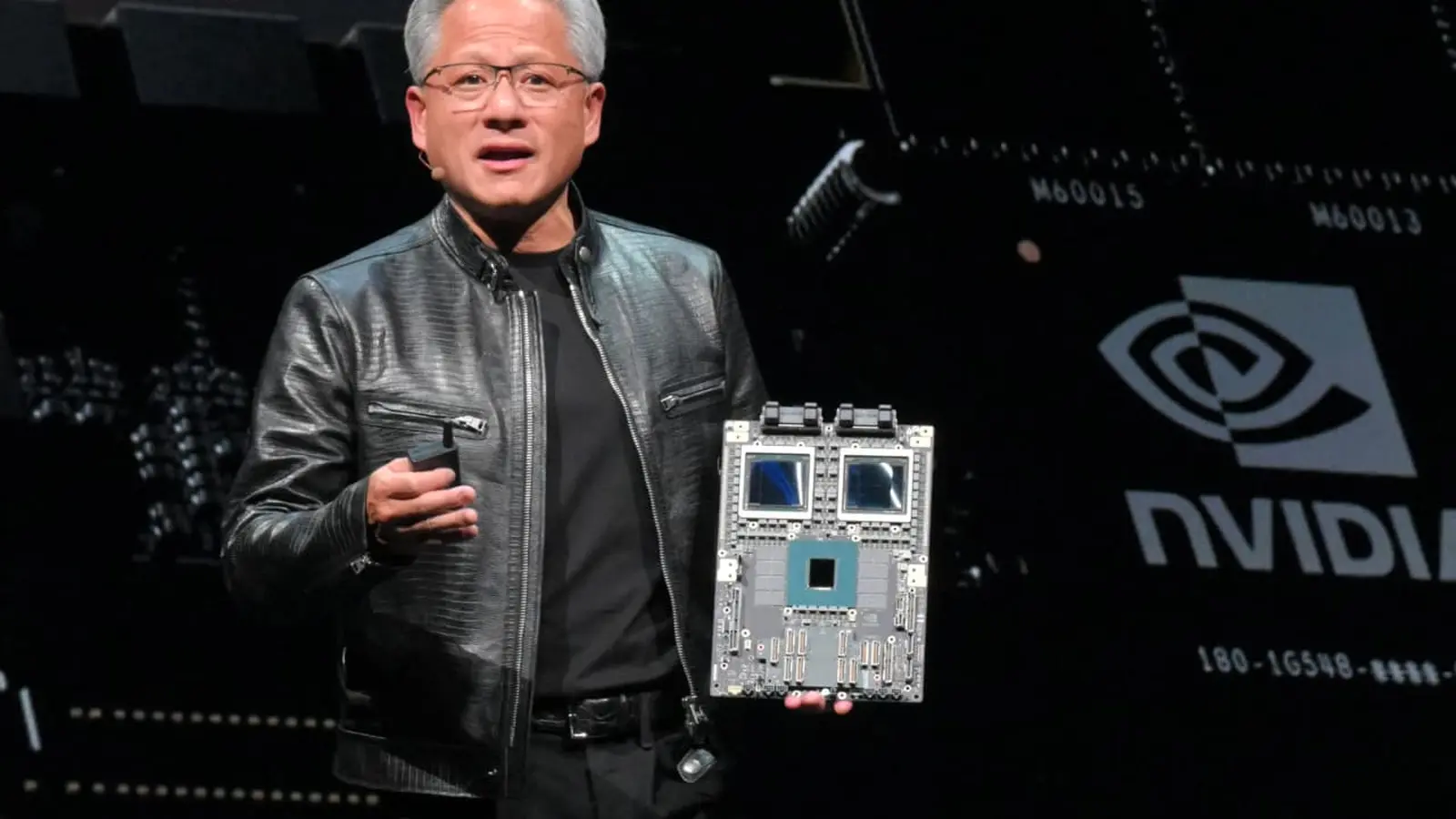

Podczas niedawnych odwiedzin w TSMC prezes Jensen Huang potwierdził, że układy GPU Rubin są już widoczne na liniach produkcyjnych. To znaczące przyspieszenie w stosunku do poprzednich etapów – oficjalna informacja o pojawieniu się gotowych próbek laboratoryjnych pojawiła się niedawno, co jest nietypowym tempem w przechodzeniu od prototypu do widoczności produkcyjnej. Jeżeli te doniesienia się potwierdzą, wejście Rubina na rynek przyspieszy go jako główny akcelerator AI dedykowany centrom danych o superskali.

Łańcuch dostaw: nowe działania TSMC i pojawienie się HBM4

Popyt na rodzinę GPU Blackwell od NVIDIA wciąż pozostaje bardzo wysoki, a TSMC intensywnie działa, by nadążyć za zamówieniami producenta akceleratorów AI. Według źródeł fabryka zwiększyła moce produkcyjne 3 nm o około 50%, by sprostać wymaganiom NVIDII. Prezes TSMC, C.C. Wei, przyznał, że NVIDIA domaga się znacząco większej liczby wafli krzemowych, chociaż dokładne dane pozostały tajemnicą handlową.

Jak wynika z informacji branżowych, NVIDIA otrzymała także próbki HBM4 od wszystkich liczących się producentów DRAM. Pamięć HBM4 ma zapewnić Rubinowi odpowiednią przepustowość oraz niskie opóźnienia niezbędne do obsługi wielkoskalowych modeli AI. Dzięki dywersyfikacji dostaw NVIDIA minimalizuje ryzyko związane z ewentualnymi niedoborami pamięci.

Terminarz, masowa produkcja i oczekiwania wobec Rubina

NVIDIA przewiduje, że Rubin trafi do masowej produkcji w trzecim kwartale 2026 roku lub nawet nieco wcześniej. Warto rozgraniczyć wczesne, testowe partie produkcyjne od faktycznej masowej produkcji: pierwsze próbki i linie pilotażowe służą weryfikacji jakości krzemu i opakowania, natomiast uruchomienie masowej produkcji oznacza początek wysyłek w dużych wolumenach do dostawców chmury oraz producentów OEM.

Nowy Superchip Rubin już dzisiaj odgrywa strategiczną rolę w spodziewanych zmianach na rynku AI. Plan rozwoju NVIDII oraz partnerska, miliardowa współpraca z OpenAI sygnalizują, że właśnie te układy przyczynią się do umożliwienia kolejnej generacji wdrożeń dużych modeli sztucznej inteligencji.

Znaczenie Rubina dla infrastruktury AI

Wyobraźmy sobie centra danych wyposażone w akceleratory klasy Rubin oraz pamięć HBM4: wyższa przepustowość, krótszy czas uczenia modeli i większa gęstość klastrów inferencyjnych. Dla dostawców usług chmurowych, producentów układów scalonych i laboratoriów AI przechodzenie Rubina do produkcji seryjnej — w połączeniu ze zwiększeniem mocy przez TSMC i zróżnicowanym łańcuchem dostaw HBM4 — istotnie ogranicza ryzyko przestojów w obliczu dynamicznego wzrostu rozmiarów modeli sztucznej inteligencji.

Szybkość wdrożenia Rubina — czy trafi on na rynek wcześniej czy zgodnie z bardziej ostrożnym harmonogramem — wpłynie na konkurencyjność w obrębie GPU, CPU oraz wyspecjalizowanych akceleratorów AI. Obecnie główne trendy to ogromny popyt, intensywne wsparcie ze strony odlewni półprzewodników oraz producentów pamięci gotowych dostarczać rozwiązania dla nowej generacji sprzętu AI.

Technologiczna przewaga i nowa fala inwestycji w AI

Premiera Superchipu Vera Rubin stanowi punkt zwrotny na rynku akceleratorów AI. Zaawansowane GPU oraz szybka pamięć HBM4 wspierają rozwój najbardziej wymagających, wielkoskalowych modeli językowych i generatywnych sieci neuronowych. Unikalna architektura sprawia, że Rubin znajduje się w centrum uwagi inwestorów oraz branży wdrażającej rozwiązania AI w chmurze, przemyśle i badaniach naukowych.

- Architektura GPU + CPU + HBM4 pozwala uzyskać najwyższą wydajność obliczeniową przy minimalnych opóźnieniach transmisji danych.

- Dywersyfikacja dostawców DRAM minimalizuje ryzyka związane z łańcuchem dostaw.

- Ścisła współpraca NVIDII z TSMC umożliwia masową produkcję zaawansowanych układów 3nm.

- Rubin napędza migrację infrastruktury chmurowej do standardów obsługujących kolejną generację modeli AI.

Wyjątkowe możliwości Superchipu Rubin

Pod względem technicznym Rubin stanowi przełom. Jego wydajność wyprzedza dotychczasowe układy z rodziny Blackwell, oferując:

- Zwiększoną skalowalność klastra AI dzięki integracji z pamięcią HBM4 o bardzo wysokiej przepustowości.

- Wsparcie dla obliczeń wieloprecyzyjnych, co pozwala obsłużyć wiele typów typów modeli uczenia maszynowego równocześnie.

- Redukcję zużycia energii na jednostkę pracy dzięki nowoczesnemu procesowi produkcji 3nm TSMC.

- Obniżenie opóźnień podczas trenowania i wykorzystywania dużych modeli LLM.

Perspektywy rozwoju rynku sprzętu AI w latach 2026–2028

Analitycy prognozują dynamiczny wzrost inwestycji w zaawansowane akceleratory AI – zarówno w sektorze usług chmurowych, jak i modernizacji infrastruktury badawczej na uczelniach i w korporacjach. Rubin, jako zapowiedziany produkt już notowany w planach największych graczy, będzie prawdopodobnie wyznaczał nowe standardy efektywności kosztowej oraz mocy obliczeniowej w AI.

Jak Rubin wpłynie na środowisko operacyjne centrów danych?

Nowa jakość rozwiązań GPU i pamięci HBM4 umożliwi organizacjom szybkie wdrożenia rozwojowych językowych modeli AI (LLM), systemów AI-Generative, klastrów uczenia przez wzmacnianie czy rozległych modeli predykcyjnych w przemyśle, zdrowiu oraz finansach.

Podsumowanie: Rubin katalizatorem zmiany w AI

Wejście Superchipu Vera Rubin do masowej produkcji i szeroka dostępność pamięci HBM4 zwiastują przełomową transformację infrastruktury AI. W efekcie centra danych zyskają możliwość obsługi coraz większych i bardziej złożonych modeli, podczas gdy łańcuch dostaw komponentów AI zostanie zabezpieczony przed niedoborami. NVIDIA, współpracując intensywnie z TSMC i liderami rynku pamięci DRAM, umacnia pozycję lidera rozwoju akceleratorów AI i otwiera nowy etap w ewolucji rozwiązań obliczeniowych dla sztucznej inteligencji.

Źródło: wccftech

Zostaw komentarz