3 Minuty

Samsung zdobywa duże zamówienie na HBM3E od Nvidia

Koreański raport informuje, że Samsung dostarczy 10 000 sztuk pamięci HBM3E z 12-warstwowymi stosami firmie Nvidia, z przeznaczeniem do serwerów AI i akceleratorów obliczeniowych. Ta dostawa, jeśli zostanie potwierdzona, oznaczać będzie ważny krok dla działu pamięci Samsunga, który coraz silniej inwestuje w segment pamięci o wysokiej przepustowości, kluczowej dla współczesnych obciążeń sztucznej inteligencji.

Czym prawdopodobnie są te układy?

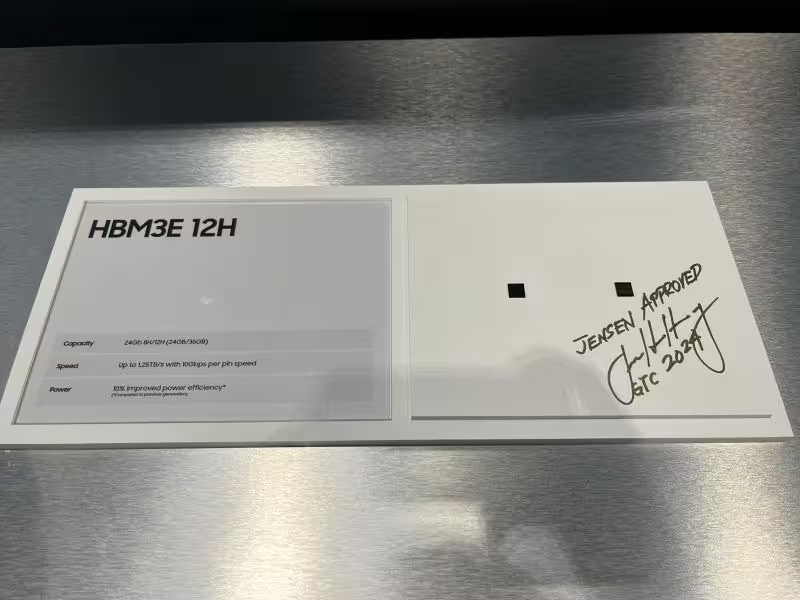

Eksperci branży przewidują, że chodzi tu o moduły Samsung HBM3E-12H – flagowe stosy 36 GB, które firma zaprezentowała w ubiegłym roku. Wyróżniają się one dużą pojemnością oraz wysoką wydajnością – oferując przepustowość sięgającą 1 280 GB/s na stos, co czyni je idealnym rozwiązaniem do treningu i inferencji AI na dużą skalę, gdzie pamięć często stanowi wąskie gardło.

Najważniejsze informacje w skrócie

- Źródło: raport AlphaBiz z Korei

- Ilość: 10 000 modułów HBM3E 12-warstwowych

- Prawdopodobny produkt: HBM3E-12H, 36 GB na stos

- Główny klient: Nvidia, zastosowania do akceleratorów AI i serwerów

Dlaczego to ma znaczenie

Akceleratory AI Nvidia, podobnie jak produkty innych producentów, bazują na pamięciach o wysokiej przepustowości, by sprawnie przesyłać duże modele i aktywacje między procesorem a pamięcią. Obecnie tylko kilka firm może dostarczać HBM3E na dużą skalę — Samsung, SK Hynix i Micron — dlatego każde nowe porozumienie może wpłynąć na rynek. Do niedawna Samsung miał trudności ze spełnieniem rygorystycznych wymagań jakościowych Nvidia, która kupowała głównie od konkurencji. Według raportów Samsung usunął przeszkody i uzyskał akceptację Nvidia, co umożliwiło realizację kontraktu.

Kontekst rynkowy i techniczny

Wielkie firmy technologiczne i dostawcy chmur stale rozbudowują farmy serwerów AI, co daje trwały popyt na HBM3E. Ta pamięć, dzięki połączeniu dużej pojemności i przepustowości, przyspiesza obciążenia związane z uczeniem modeli językowych oraz szybkim wnioskowaniem. Kontrakt na taką skalę może:

- Umocnić pozycję Samsunga na rynku HBM

- Dostarczyć Nvidia większej dywersyfikacji dostawców kluczowej pamięci

- Mieć potencjalny wpływ na ceny i dostępność w całym ekosystemie

Perspektywy i znaczenie

Jeśli dane AlphaBiz się potwierdzą, zamówienie na 10 000 sztuk jest wprawdzie początkowe, lecz istotne – i może stanowić preludium do kolejnych, większych kontraktów w miarę rozwoju nowych linii akceleratorów Nvidia i ekspansji w centrach danych klasy hiperskali. Dla Samsunga zdobycie tak prestiżowego klienta oznacza nie tylko wymierne przychody, lecz także potwierdzenie, że technologia HBM3E spełnia surowe wymogi wydajności i niezawodności.

Finalnie ta sytuacja pokazuje, że łańcuchy dostaw pamięci stają się strategicznymi zasobami w świecie obliczeń opartych na AI. Zarówno producenci chipów, jak i operatorzy chmur będą z uwagą obserwować dalszy rozwój sytuacji, realizację dostaw oraz wszelkie oficjalne komentarze Samsunga i Nvidia, by lepiej zrozumieć możliwości i skutki tej współpracy.

Źródło: sammobile

Zostaw komentarz