5 Minuty

Wprowadzenie: Czego użytkownicy naprawdę oczekują od agentów AI?

Zespół badawczy Apple podjął próbę odpowiedzi na kluczowe pytanie: czego naprawdę oczekują użytkownicy od agentów AI wspomagających codzienne obowiązki? Odpowiedzi okazują się złożone, pełne kompromisów i typowo ludzkich dylematów.

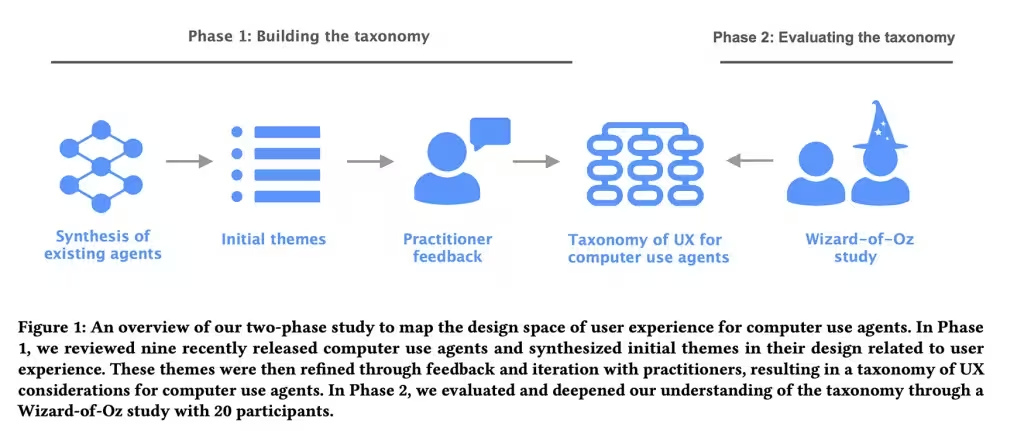

W ramach publikacji Mapping the Design Space of User Experience for Computer Use Agents badacze przyglądnęli się dziewięciu realnym agentom AI: Claude Computer Use Tool, Adept, OpenAI Operator, AIlice, Magentic-UI, UI-TARS, Project Mariner, TaxyAI i AutoGLM. Analiza miała na celu stworzenie mapy tego, jak te systemy prezentują swoje możliwości, radzą sobie z błędami oraz jak zapraszają użytkownika do współkontroli. W pierwszym etapie osiem osób specjalizujących się w UX i AI zebrało obserwacje i sklasyfikowało je w cztery główne kategorie, 21 podkategorii i 55 praktycznych cech projektowych. Obejmuje to między innymi, jak użytkownicy przekazują polecenia agentowi AI, jak transparentne są działania agenta, jaką kontrolę zachowuje użytkownik oraz w jaki sposób kształtują się modele mentalne i oczekiwania odbiorców.

Metodologia badań: Eksperyment Czarnoksiężnika z Krainy Oz

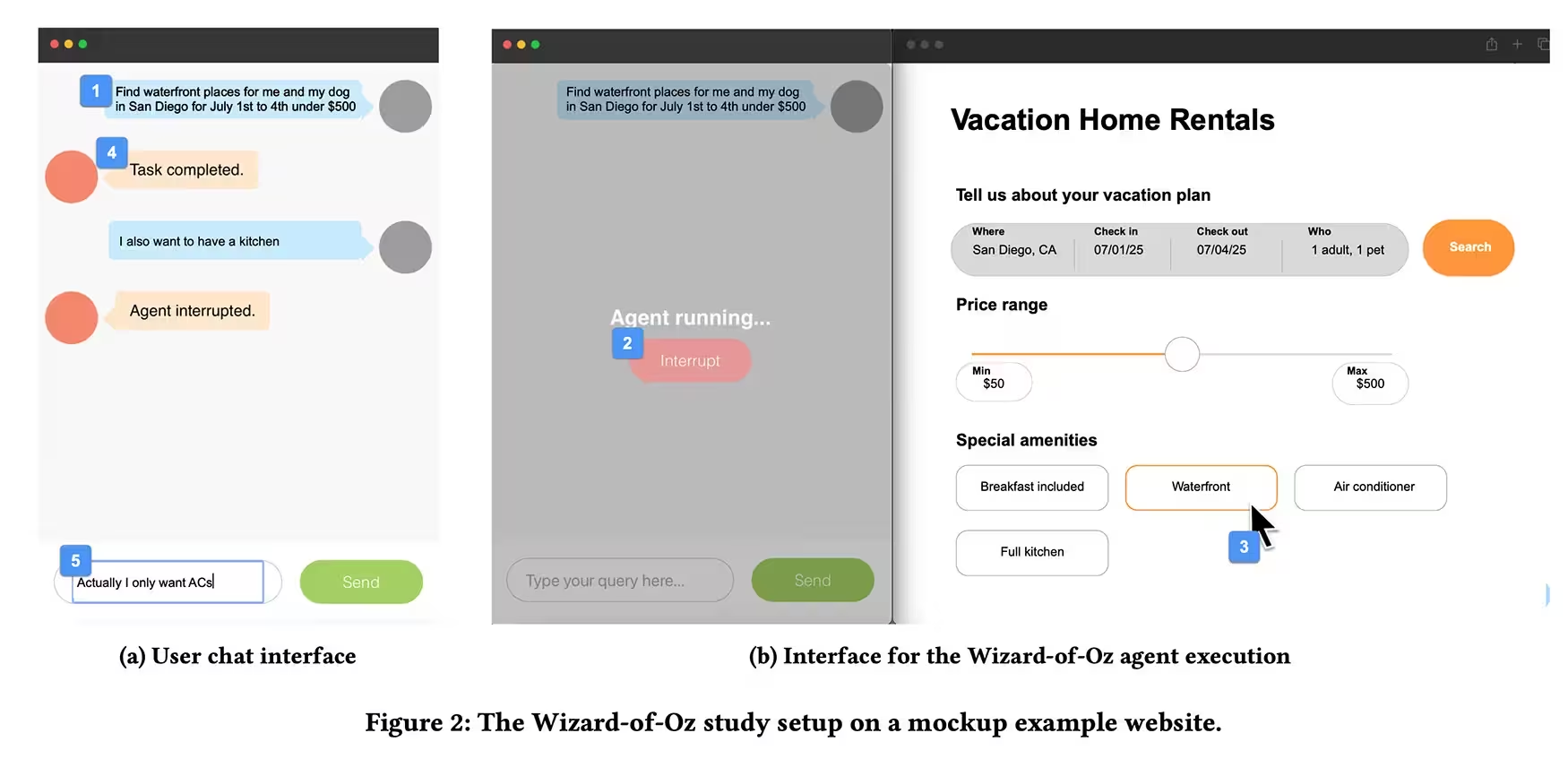

W kolejnym etapie badacze przeprowadzili eksperyment metodą „Wizard of Oz”. Dwudziestu uczestników mających wcześniejsze doświadczenie w korzystaniu z asystentów AI realizowało zadania – od rezerwacji wakacji po zakupy online – korzystając z interfejsu czatu. Jednak realnie to ukryty za kulisami badacz sterował agentem za pomocą klawiatury i myszy. Uczestnicy mogli wydawać polecenia tekstowe i użyć przycisku „zatrzymaj”, by przerwać działanie agenta. Część zadań została celowo zakłócona błędami lub niespodziewanymi przerwami, by zobaczyć reakcję użytkowników w sytuacji, gdy agent AI popełnia błąd lub wychodzi poza schemat.

Wyniki: Przejrzystość i kontrola jako fundament zaufania

Z eksperymentu wyłonił się spójny obraz potrzeb użytkowników. Większość osób oczekuje przejrzystości – chcą widzieć, co robi agent AI, lecz bez konieczności zarządzania każdym szczegółem. Krótkie demonstracje oraz sporadyczne potwierdzenia dają komfort. Zupełna cisza ze strony systemu rodzi podejrzenia, a automatyzacja bez wyjaśnień – nieufność. Początkujący cenią sobie szczegółowe, krok po kroku, wyjaśnienia oraz tzw. miękkie punkty kontrolne, zwłaszcza przy istotnych działaniach (np. zakupach, zmianach w koncie), które trudno odwrócić. Zaawansowani użytkownicy wolą, by agent działał jak zaufany współpracownik, a nie ostrożny pomocnik.

Zaufanie do agentów AI – kruche jak szkło

Badanie wykazało, że zaufanie jest niezwykle delikatne: utrata go następuje szybciej w wyniku ukrytych założeń lub drobnych błędów niż budowa w wyniku bezproblemowego działania. Gdy agent AI wychodził poza schemat lub pojawiała się niejasność, użytkownicy woleli, by system zatrzymał się i zapytał, zamiast zgadywać i działać samodzielnie. Taka preferencja utrzymywała się nawet wtedy, gdy konieczność dodatkowego potwierdzenia była minimalnie irytująca – użytkownicy mówili jasno: lepiej dmuchać na zimne.

Projektuj agentów AI tak, aby poziom przejrzystości i kontroli odpowiadał zarówno specyfice zadania, jak i doświadczeniu użytkownika.

Wskazówki dla projektantów i twórców aplikacji

Na podstawie obserwacji można wyciągnąć praktyczne wnioski dla projektantów interfejsów użytkownika i deweloperów aplikacji opartych na AI:

- Pokaż użytkownikom intencje agenta oraz postęp realizowanych działań;

- Pozwól łatwo zatrzymać, poprawić lub zmodyfikować zadanie w trakcie procesu;

- Dostosuj poziom prezentowanych wyjaśnień do stopnia skomplikowania zadania oraz doświadczenia użytkownika z narzędziem;

- Testuj rozwiązania w praktyce, korzystając z ponad 50 wskazówek i cech projektowych zaprezentowanych w modelu Apple.

Opracowane przez Apple ramy projektowe nie są tylko teoretyczną propozycją – dostarczają realnych narzędzi do iteracyjnego sprawdzania i ulepszania systemów AI w oparciu o rzeczywiste zachowania użytkowników.

Znaczenie mądrych interakcji z AI – poza doskonałością modeli

Rozwój sztucznej inteligencji nie sprowadza się wyłącznie do coraz lepszych modeli uczenia maszynowego. Współczesne wyzwania obejmują głównie projektowanie interakcji, które budują zaufanie do automatyzacji. Krótkoterminowo nie są to spektakularne zmiany, lecz właśnie te drobne decyzje – czytelne potwierdzenie, jawny krok, przemyślana pauza – przesądzają o tym, czy użytkownicy zaakceptują automatyzację i będą jej ufać, czy też z niej zrezygnują.

Podsumowanie: Lekcje Apple dla przyszłości agentów AI

Z badań Apple wynika, że projektowanie agentów AI wspierających użytkownika w codziennych zadaniach wymaga połączenia technicznej precyzji z głębokim zrozumieniem ludzkich potrzeb. Przejrzystość, kontrola oraz elastyczne dostosowanie doświadczenia to klucz do zbudowania trwałego zaufania do autorskich rozwiązań opartych na AI, zarówno dla mniej, jak i bardziej zaawansowanych użytkowników internetu.

Źródło: smarti

Zostaw komentarz