5 Minuty

Giganci chmurowi kupują pamięć półprzewodnikową niczym cenny kruszec. Zamówienia tzw. hiperskalerów osiągnęły taką skalę, że ceny szybują w górę, a łańcuchy dostaw ledwo nadążają z realizacją zapotrzebowania. Pamięć HBM – wysokoprzepustowa i wydajna energetycznie – stała się kluczowym zasobem napędzającym współczesne centra danych, uczenie maszynowe oraz generatywną sztuczną inteligencję.

Rosnące zapotrzebowanie na wydajną pamięć: prognozy i wyzwania rynku

Podczas konferencji Semicon Korea, Song Jai-hyuk, CTO jednostki Device Solutions w firmie Samsung, przedstawił realia rynkowe i prognozy na nadchodzące lata. Wskazał jednoznacznie: popyt na wysokowydajną pamięć dynamicznie wzrasta nie tylko obecnie, ale według analiz pozostanie wysoki przynajmniej do 2027 roku. To krótka informacja, lecz niosąca ogromne konsekwencje dla całego rynku półprzewodników oraz usług chmurowych.

HBM4 – przełomowa generacja pamięci dla AI i analityki danych

Samsung koncentruje się obecnie na technologii HBM4 – najnowszej generacji wysokoprzepustowej pamięci masowej, zaprojektowanej z myślą o obciążeniach obliczeniowych stawianych przez nowoczesne modele sztucznej inteligencji. Po udanej serii sprzedaży HBM3E w trzecim i czwartym kwartale poprzedniego roku, firma zamierza już w pierwszym kwartale rozpocząć masową wysyłkę HBM4.

Pierwsi klienci korporacyjni, którzy otrzymali egzemplarze HBM4, podkreślają bardzo wysoką satysfakcję z parametrów tej pamięci. Szybkość transferu danych i efektywność energetyczna wyraźnie odpowiadają na rosnące oczekiwania rynku centów danych i przemysłu AI.

Technologiczne innowacje i zaawansowane pakowanie

Firma nie ogranicza się jednak tylko do zwiększania pojemności układów pamięci. Intensywnie rozwijane są również technologie pakowania oraz rozwiązania z zakresu chemii termicznej. Jednym z przełomów, które Samsung wprowadza do produkcji, jest hybrydowe łączenie stosów HBM. Dzięki modyfikacji sposobu łączenia matryc, uzyskano nawet 20% spadek oporu cieplnego w stosach 12- i 16-warstwowych oraz o około 11% niższą temperaturę matrycy bazowej podczas testów laboratoryjnych. Schłodzone pamięci to większa wydajność i niezawodność całego systemu.

Nowatorskie architektury: zHBM i wydajność na osi Z

Na deskach kreślarskich Samsunga pojawił się również zHBM – koncepcja, w której układy pamięci są rozmieszczane wzdłuż osi Z. Jest to rozwiązanie rewolucyjne, umożliwiające nawet czterokrotne zwiększenie przepustowości przy jednoczesnym ograniczeniu zapotrzebowania na energię o około 25%. Tego typu zmiany architektury mogą znacząco wpłynąć na równowagę pomiędzy wydajnością a kosztami energii centrów danych.

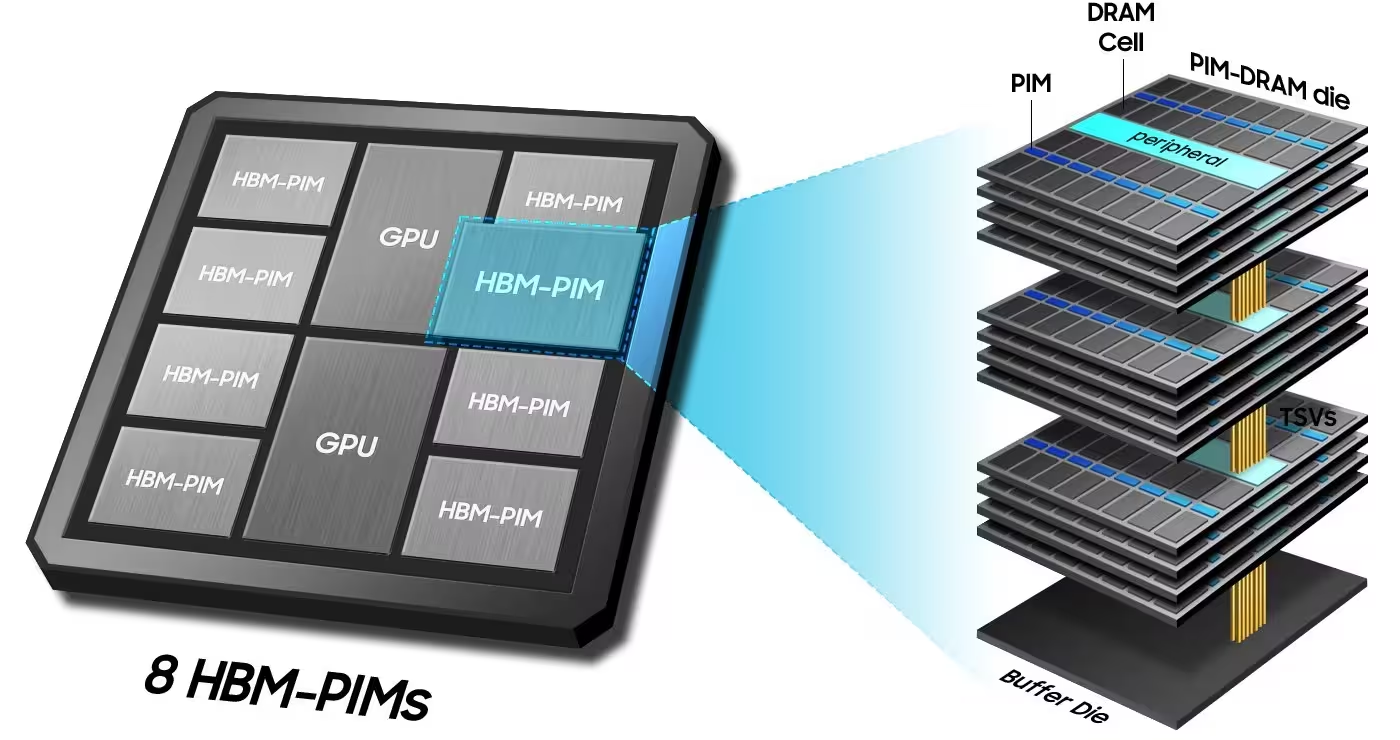

Processing-in-Memory – komputer blisko danych

Pojęcie Processing-in-Memory (PIM) to kolejny istotny element innowacji. Samsung eksperymentuje z autorskimi konfiguracjami HBM, gdzie elementy obliczeniowe są umieszczane bezpośrednio w stosach pamięci. Efekt? Około 2,8 razy wzrost wydajności przy zachowaniu energooszczędności. Przełomowy układ HBM-PIM został już przetestowany w konfiguracji opartej o AMD Instinct MI100, co dowodzi, że ścisła integracja pamięci z logiką pozwala radykalnie przyspieszyć analizę i przetwarzanie danych.

- HBM4: Premiera przewidziana na I kwartał, zoptymalizowana pod AI i obliczenia HPC.

- Łączenie hybrydowe: Nowe techniki montażu to niższe temperatury i większa wydajność.

- zHBM: Innowacyjny układ na osi Z, przełom w architekturze pamięci.

- PIM: Integracja funkcji obliczeniowych bezpośrednio w stosach HBM.

Podsumowując: firmy hiperskalowe kreują rekordowy popyt na wydajną pamięć, a Samsung odpowiada innowacjami – HBM4, hybrydowe łączenie, zHBM i PIM nie tylko zwiększają przepustowość, ale również ograniczają problemy cieplne i energetyczne.

Przyszłość rynku HBM: innowacje kontra rzeczywistość wdrożeń

Daty premiery komercyjnych produktów z hybrydowym łączeniem czy zHBM nie są jednak jasno określone. Właśnie tu leży główne wyzwanie rynku: czy technologie laboratoryjne staną się standardem rackowych systemów serwerowych w tempie, którego wymaga popyt?

- Szybkość adopcji: Jak sprawnie rozwiązania przejdą z fazy badań do produkcji masowej?

- Skalowalność: Które z innowacji będą wdrożone globalnie, a które pozostaną niszowe?

- Wpływ na centra danych: Czy nowe pamięci zredukują energochłonność bez kompromisów w wydajności?

Nadchodzący rok pokaże, które technologie zostaną zaakceptowane przez rynek, a które pozostaną jedynie eksperymentalne. Trwa zacięty wyścig, w którym liczy się zarówno innowacyjność, jak i zdolność szybkiego wdrożenia na masową skalę.

Podsumowanie: Kto dotrzyma tempa nowej generacji pamięci?

Wszystko wskazuje na to, że rynek pamięci HBM czeka wieloletni okres dynamicznego rozwoju. Pytanie brzmi: kto nadąży w tym wyścigu technologicznym? Liderzy branży inwestują w zaawansowane rozwiązania, by sprostać oczekiwaniom coraz większych obciążeń związanych ze sztuczną inteligencją, chmurą obliczeniową i analizą big data. HBM4, zHBM oraz koncepcje Processing-in-Memory będą odgrywały zasadniczą rolę w przemianach infrastruktury IT. Odpowiedź na to, które firmy wyznaczą tempo rynkowych zmian, przyniosą najbliższe miesiące.

Źródło: gsmarena

Zostaw komentarz