4 Minuty

Samsung umacnia swoją pozycję jako kluczowy dostawca pamięci dla serwerów AI najnowszej generacji firmy Nvidia. Koncern deklaruje, że w 2026 roku dostarczy połowę wszystkich nowych modułów DRAM SOCAMM2 potrzebnych Nvidii. Decyzja ta jest efektem intensywnych prac nad udoskonaleniem wysokowydajnych pamięci DRAM oraz HBM w ciągu ostatniego roku, co znacząco wpłynęło na konkurencyjność Samsunga na rynku komponentów do sztucznej inteligencji.

Znaczenie sukcesu Samsunga w projekcie SOCAMM2

W ubiegłym roku Samsung w dużej mierze nie skorzystał z dynamicznego wzrostu zapotrzebowania na pamięci dedykowane do AI, jednak ostatnio poprawił wydajność linii produkcyjnych i jakość swoich zaawansowanych układów DRAM. Firma przesłała już próbki pamięci HBM4 do Nvidii w celu ostatecznej walidacji, a obecnie potwierdza, że dostarczy około 50% modułów Small Outline Compression Attached Memory Module 2 (SOCAMM2), na które liczy Nvidia w kolejnym roku.

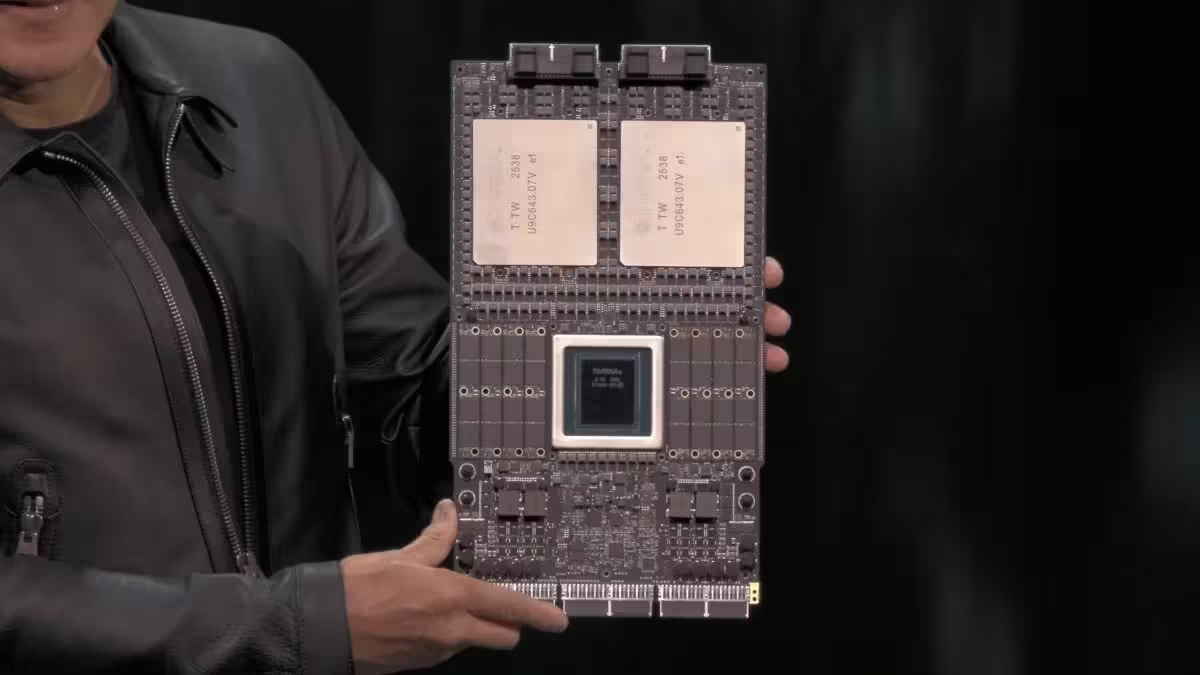

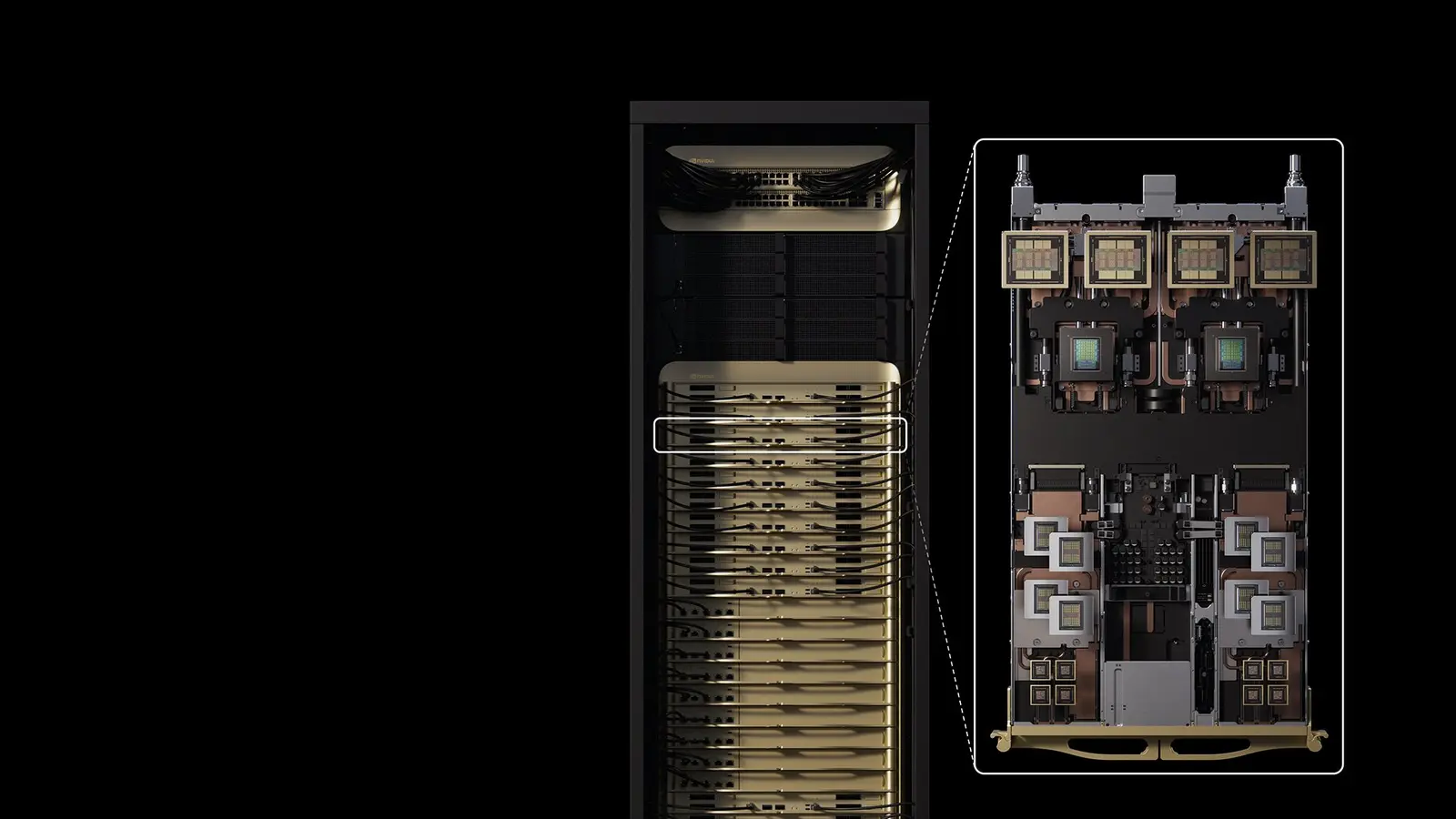

Moduły SOCAMM2 to nowoczesna, zoptymalizowana pod kątem serwerów technologia pamięci, która łączy wiele układów LPDDR na jednym podłożu. Dzięki temu ułatwia proces rozbudowy oraz pozwala osiągnąć większą gęstość pamięci w centrach danych AI. Przykładowo, platformy Vera firmy Nvidia rozmieszczają kilka modułów SOCAMM2 obok procesorów Vera, by efektywnie zasilać układy GPU Rubin bardzo szerokopasmowymi danymi.

Tegorocznym liderem wdrożeń SOCAMM była firma Micron, jednak Samsung oraz SK Hynix nie pozostają w tyle. Samsung informuje, że ustabilizował wydajność w produkcji układów DRAM piątej generacji (1c), które są kluczowym elementem SOCAMM2. Pozwoliło to na efektywne skalowanie produkcji i spełnienie rosnących wymagań branży AI.

Skala produkcji i dostawy: szczegółowe dane

Nvidia zasygnalizowała producentom pamięci, że potrzebuje nawet 20 miliardów gigabajtów (GB) modułów SOCAMM. W świetle obecnych ustaleń, Samsung zamierza pokryć połowę tego zapotrzebowania, czyli około 10 miliardów GB. Do uzyskania takich wyników potrzebnych będzie około 830 milionów układów DRAM LPDDR5X 24Gb, co odpowiada produkcji 30 000–40 000 wafli miesięcznie. Stanowi to około 5% całkowitej miesięcznej produkcji wafli DRAM w fabrykach Samsunga.

Pozostały popyt na moduły SOCAMM2 mają zaspokoić Micron oraz SK Hynix. Dla Samsunga zdobycie tak dużych kontraktów na SOCAMM2 oraz potencjalnych zamówień na HBM4 może przynieść znaczne wzrosty przychodów i zysków, szczególnie że wydatki na infrastrukturę AI wciąż rosną na całym świecie.

Co dalej? W najbliższych latach można się spodziewać jeszcze szerszej adaptacji standardu SOCAMM2 w serwerach AI, zwłaszcza w miarę wzrostu produkcji u kluczowych dostawców. Warto również śledzić, jak Samsung radzi sobie z walidacją HBM4 u Nvidii – oba te czynniki zdefiniują przyszły kształt łańcucha dostaw i ceny pamięci w 2026 roku.

Przyszłość pamięci dla sztucznej inteligencji

Dynamiczny rozwój rynku serwerów AI wymusza innowacje w zakresie pamięci operacyjnej i masowej. SOCAMM2 to odpowiedź na rosnące potrzeby w dziedzinie przetwarzania dużych zbiorów danych. Kluczowe cechy tej technologii to:

- Bardzo wysoka gęstość modułów pamięci (idealna dla centrów danych AI).

- Prostota rozbudowy i wymiany komponentów bez konieczności przerywania pracy systemów.

- Optymalizacja pod kątem energooszczędności oraz wysokiej przepustowości danych.

Samsung, prowadząc ścisłą współpracę z Nvidią, dodatkowo wzmacnia konkurencyjność poprzez ciągłe udoskonalanie procesów produkcyjnych i badania nad kolejnymi generacjami pamięci DRAM oraz HBM. Już teraz próbki HBM4 testowane są pod kątem wydajności przy obliczeniach AI, a skuteczne wdrożenie tej technologii w serwerach może przyczynić się do redefinicji standardów na rynku pamięci dla sztucznej inteligencji.

Wyzwania na rynku pamięci wysokiej wydajności

Dynamiczny popyt na pamięci SOCAMM2 oraz HBM4 wiąże się z szeregiem wyzwań – zarówno technologicznych, jak i logistycznych. Kluczowe dla sukcesu będą:

- Utrzymanie stabilnych i wysokich uzysków z produkcji wafli DRAM (yield management).

- Dostosowanie łańcucha dostaw do ekspansji rynkowej AI i szybkich zmian w strukturze zamówień.

- Konkurencja ze strony innych gigantów, takich jak Micron i SK Hynix, którzy również rozwijają ofertę dla AI.

Warto zaznaczyć, że branża serwerowa i AI jest podatna na wahania popytu, co wpływa na cykl inwestycyjny i strategię rynkową producentów pamięci DRAM.

SOCAMM2 i HBM4 – klucz do innowacji w AI

Pojawienie się SOCAMM2 i HBM4 otwiera nowe możliwości nie tylko dla Nvidii i Samsunga, ale dla całego sektora przetwarzania wysokowydajnego. Dzięki własnej technologii LPDDR5X oraz innowacjom w konstrukcji wafli, Samsung może zapewnić odpowiednią jakość i skalowalność. Przypomina to istotną rolę, jaką pełnią te firmy w globalnym ekosystemie centrów danych dostępnych na potrzeby sztucznej inteligencji.

W dłuższej perspektywie można spodziewać się, iż technologie te zyskają uznanie również w innych sektorach wymagających ekstremalnej wydajności – od przetwarzania graficznego po superkomputery wykorzystywane w nauce i analizie Big Data.

Konkluzja: Samsung i Nvidia – nowy standard w pamięciach dla AI

Sukces Samsung w zabezpieczeniu dużych zamówień na SOCAMM2 dla Nvidii wyznacza nowy etap rozwoju rynku pamięci przeznaczonej do zaawansowanej sztucznej inteligencji. Konsekwentna praca nad produkcją DRAM i HBM4, a także partnerstwo technologiczne z Nvidią, mogą okazać się decydujące dla dalszego rozwoju centrów danych AI na świecie. W obliczu rosnącego zapotrzebowania na wysokowydajne moduły pamięci, doświadczenie i innowacyjność Samsunga buduje solidną podstawę przyszłych sukcesów w erze eksabajtowych zbiorów danych i coraz bardziej zaawansowanych serwerów na potrzeby AI.

Źródło: sammobile

Zostaw komentarz