7 Minuty

Rodzina nowych chipów Google Ironwood TPU ponownie rozbudziła wyścig w dziedzinie sprzętu do sztucznej inteligencji. Tym razem to nie AMD ani Intel stanowią największe wyzwanie dla Nvidii, lecz opracowany przez Google autorski układ krzemowy zoptymalizowany pod zadania inferencyjne. Imponująca pojemność pamięci, zaawansowane połączenia i ambitne deklaracje dotyczące wydajności energetycznej sprawiają, że Ironwood rewolucjonizuje infrastrukturę chmurową AI na dużą skalę.

Ironwood w liczbach: pamięć, moc obliczeniowa i skalowalne SuperPody

Ironwood (TPU v7) od początku był projektowany z myślą o jednym — obsłudze modeli AI w środowisku produkcyjnym. Google prezentuje go jako układ „inference-first”, którego specyfikacja skupia się na minimalizacji opóźnień, ograniczeniu zużycia energii na zapytanie oraz upraszczaniu wdrożeń dużych modeli językowych i usług AI działających w czasie rzeczywistym.

- Maksymalna moc obliczeniowa FP8 na układ: około 4 614 TFLOPs

- Pamięć na pakiecie: 192 GB HBM3e (~7–7,4 TB/s przepustowości)

- Skalowalność podów: do 9 216 chipów na SuperPod

- Zbiorcza moc obliczeniowa na pod: ≈42,5 exaFLOPS (FP8)

- Łączna pamięć HBM na pod: ok. 1,77 PB

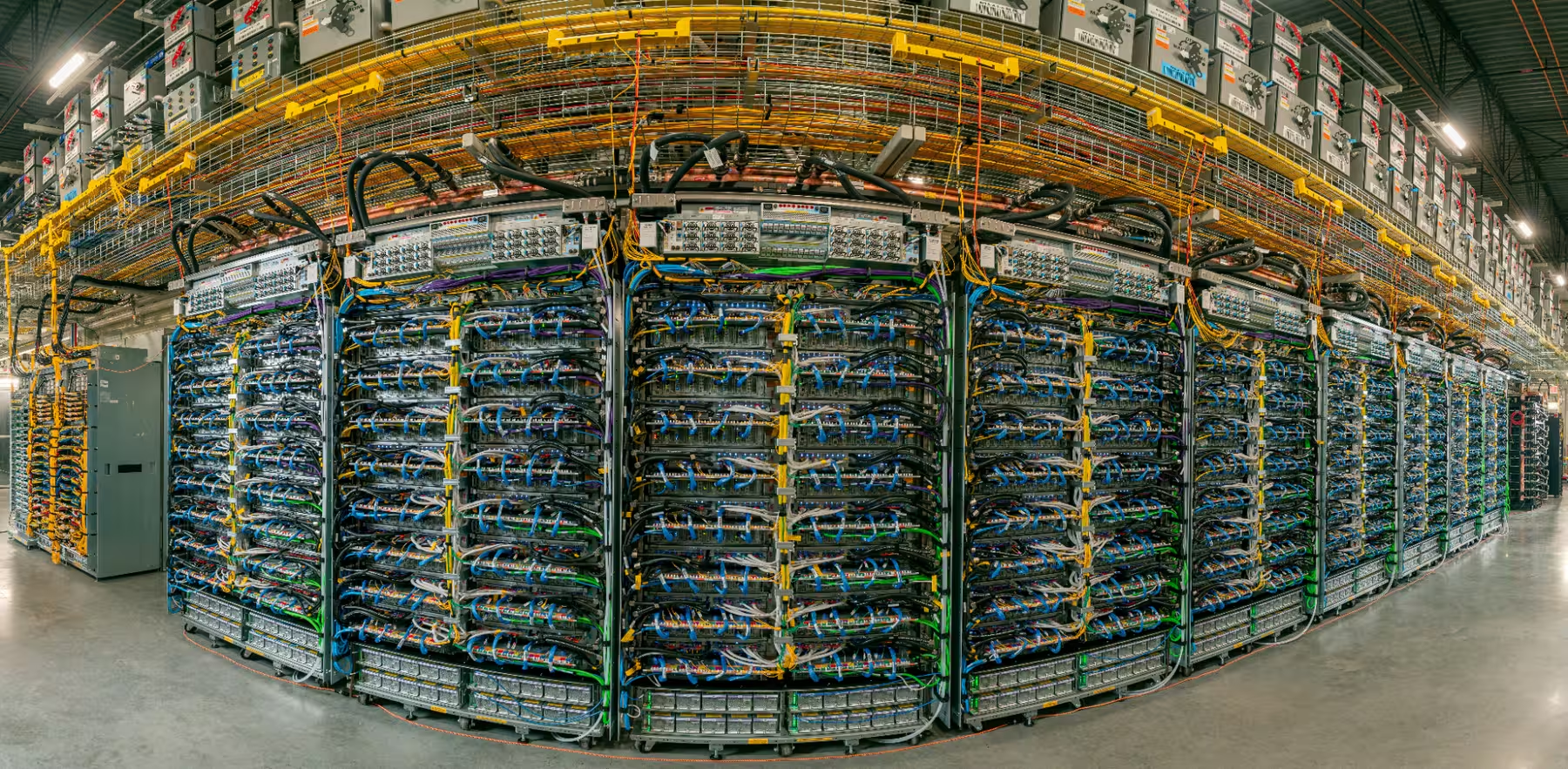

Te imponujące parametry są istotne, jednak kluczowe znaczenie ma także sposób komunikacji pomiędzy chipami. Google wykorzystuje technologię InterChip Interconnect (ICI) oraz trójwymiarową topologię torus, dzięki czemu łączy wiele układów w spójną jednostkę SuperPod. Struktura ta, wsparta wydajną siecią o przepustowości 1,8 PB między podami, pozwala utrzymać duże modele bez konieczności przesyłania ich danych przez wolniejsze łącza.

Jak inference zmienia mapę konkurencyjną w AI

Jeszcze do niedawna to trening modeli był polem rywalizacji — liczyły się surowe TFLOPs, olbrzymie zasoby pamięci i zoptymalizowane kernela, a Nvidia dominowała w tym obszarze. Obecnie gospodarka AI ewoluuje. Gdy model zostanie wytrenowany, faktyczny obszar zastosowań to nie kolejne treningi, lecz miliardy zapytań inferencyjnych. Kluczowe stają się więc opóźnienia, przepustowość, energooszczędność na zapytanie oraz efektywność kosztowa.

.avif)

Architektura Ironwood została zbudowana z myślą o tych parametrach. Rozbudowana pamięć lokalna ogranicza komunikację między układami przy obsłudze dużych modeli, a co za tym idzie – zmniejsza opóźnienia. Google deklaruje, że Ironwood zapewnia znacząco lepszą wydajność i efektywność energetyczną w porównaniu do wcześniejszych generacji TPU (wg firmy nawet dwukrotny wzrost efektywności energetycznej). Dla hyperscalerów i klientów chmurowych, którzy potrzebują całodobowej obsługi zapytań, te oszczędności przekładają się na realne korzyści finansowe.

Połączenia, SuperPody i ryzyko uzależnienia od ekosystemu

Zintegrowanie rozwiązań to kolejna przewaga Ironwood. Dzięki oferowaniu TPU w Google Cloud, firma potrafi zoptymalizować całość — od sprzętu, przez sieci, po środowisko uruchomieniowe — by zminimalizować koszt przetwarzania pojedynczego zapytania. Podejście SuperPod, bazujące na gęstej sieci połączeń i rozbudowanej strukturze skalującej, pozwala obsługiwać ogromne modele z mniejszymi stratami wydajności niż tradycyjne, rozproszone klastry GPU.

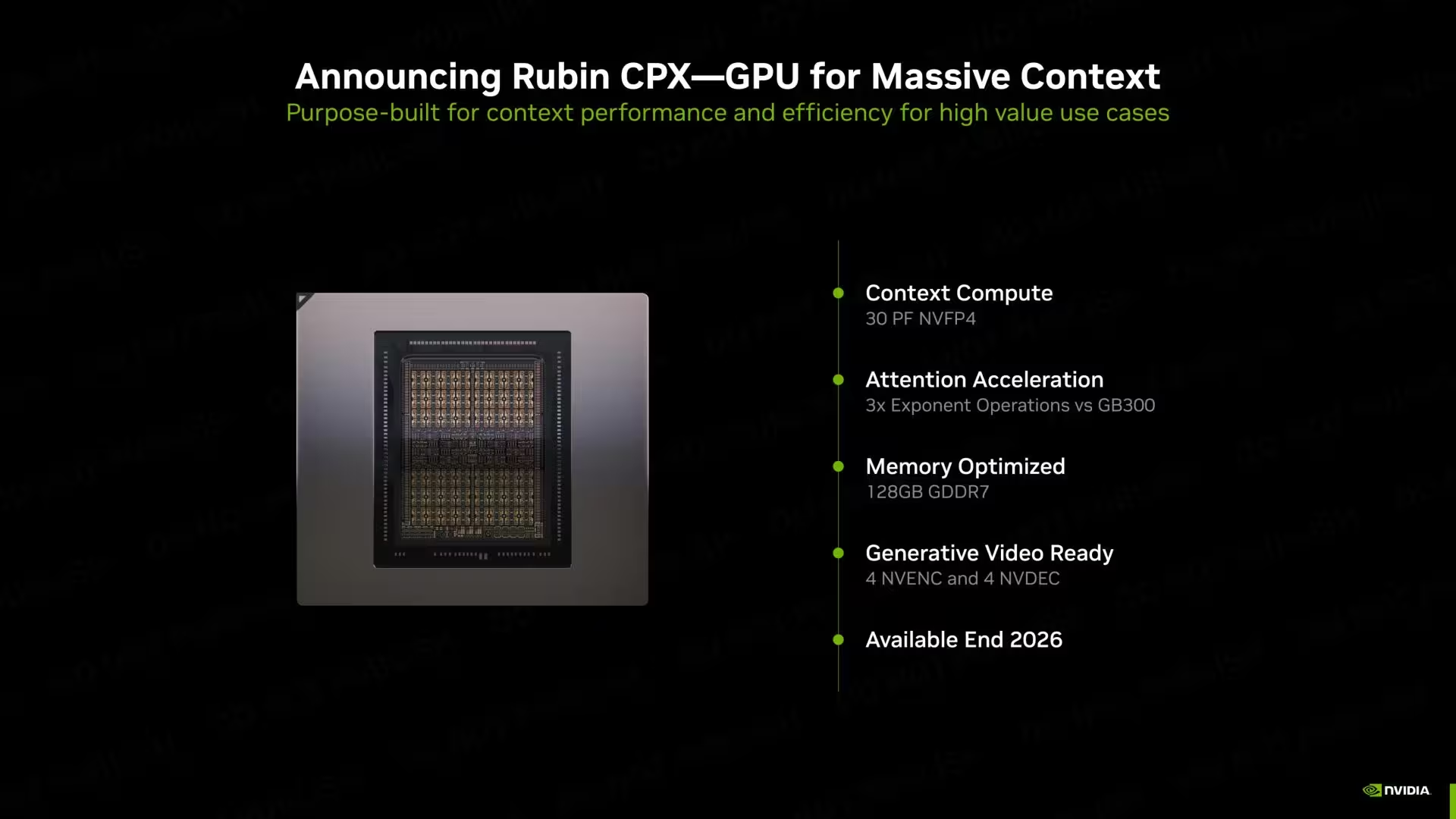

Taka pionowa integracja niesie strategiczne zagrożenia dla Nvidii. Nawet mając do dyspozycji najnowsze szafy Rubin oraz układy B200 Blackwell, dostosowane do zadań inferencyjnych, klienci chmurowi mogą preferować natywną infrastrukturę TPU, jeśli zapewnia ona mierzalne oszczędności energii i niższą latencję. Konsekwencją może być silniejsze związanie klientów z zamkniętą architekturą konkretnego dostawcy chmury.

Jensen Huang dostrzega wyzwanie

Dyrektor generalny Nvidii, Jensen Huang, publicznie przyznał, że opracowanie wyspecjalizowanych ASIC-ów to wyjątkowe wyzwanie, jednocześnie uznając TPU za realną konkurencję. Taka otwarta deklaracja jest istotna — gdy lider rynku wskazuje zagrożenie ze strony konkretnej technologii, oznacza to zwykle wzmożone inwestycje i szybsze cykle rozwojowe po obu stronach rywalizacji.

Czy to koniec dominacji Nvidii?

Zdecydowanie nie — ale reguły gry zaczynają się zmieniać. Nvidia wciąż przewodzi w zakresie uniwersalnych układów GPU, dysponuje ogromnym ekosystemem oprogramowania oraz szerokim wykorzystaniem swoich rozwiązań zarówno do treningu, jak i wielu scenariuszy inferencyjnych. Ironwood otwiera jednak zupełnie nowy wymiar konkurencji, skupiony na ekonomii zapytań. Dla firm zarządzających dużymi, stale działającymi wdrożeniami AI strategie wdrażania TPU od Google mogą być kluczowe przy wyborze platformy inferencyjnej.

W skrócie: wyścig w dziedzinie AI przekształca się z „kto ma najwięcej flopsów” na „kto obsłuży najwięcej zapytań najszybciej i najtaniej”. Wchodząc do produkcji, Ironwood sprawia, że dostawcy chmury, hyperscalerzy i przedsiębiorstwa będą na nowo analizować, gdzie uruchamiać zadania inferencyjne — czyniąc Google jednym z najciekawszych graczy całego rynku sztucznej inteligencji.

Analiza wpływu TPU Ironwood na rynek AI i jego przyszłość

Wraz z wprowadzeniem Ironwood TPU, Google jeszcze mocniej podkreśla jak ważne stają się wyspecjalizowane rozwiązania do inferencji w chmurze. Coraz więcej organizacji zdaje sobie sprawę, że koszt pojedynczego zapytania AI, szybkość reakcji systemu i efektywność energetyczna przesądzają o rentowności usług opartych o sztuczną inteligencję. Google, jako operator dużej infrastruktury chmurowej i twórca własnych technologii, jest w stanie zintegrować sprzęt oraz oprogramowanie w sposób niedostępny dla tradycyjnych dostawców GPU.

Kolejnym aspektem jest możliwość błyskawicznego skalowania. Innowacyjna architektura SuperPod oferuje dynamiczne dołączanie kolejnych układów TPU, zapewniając rosnącym aplikacjom AI późniejsze zmiany konfiguracji bez przestojów. Z punktu widzenia przedsiębiorstw, daje to przewagę nad systemami GPU, które mogą wymagać złożonego zarządzania klastrem i bardziej skomplikowanych aktualizacji.

Ekologiczne aspekty: oszczędność energii w centrum uwagi

W dobie rosnących kosztów energii i presji na ekologiczne działania, zagadnienie efektywności systemów AI nigdy nie było ważniejsze. Google podkreśla, że Ironwood osiąga nawet dwukrotnie lepszy stosunek zużycia energii do wydajności względem poprzednich generacji TPU. Dla centrów danych obsługujących setki tysięcy zapytań każdej sekundy, potencjał redukcji śladu węglowego dzięki efektywniejszym TPUs może decydować o przewadze konkurencyjnej i zgodności z normami korporacyjnymi czy ESG.

Bezpieczeństwo, skalowalność i długoterminowe strategie chmurowe

Zintegrowana infrastruktura TPU Ironwood to nie tylko kwestia wydajności i kosztów. Dla firm realizujących projekty na bazie AI kluczowa jest także skalowalność usług oraz bezpieczeństwo danych. Google, oferując własne środowisko chmurowe z usługami IAM, zaawansowanymi zabezpieczeniami i transparentnością procesów, może dostarczyć argumenty dla instytucji z branży finansowej, zdrowotnej czy publicznej, które wdrażają modele o krytycznym znaczeniu dla działania organizacji.

To właśnie pełna kontrola nad każdym elementem infrastruktury — od chipów TPU, przez warstwę sieciową, po platformę uruchomieniową — pozwala Google szybciej reagować na nowe zagrożenia, aktualizować komponenty bezpieczeństwa i skuteczniej zarządzać ryzykiem operacyjnym.

Podsumowanie: Ironwood TPU definiuje nową erę AI

Pojawienie się Ironwood TPU zapoczątkowało istotny rozdział w sektorze sprzętu AI. Efektywność energetyczna, elastyczność skalowania i spójność całego ekosystemu stawiają Google w roli nowoczesnego lidera na dynamicznym rynku infrastruktury sztucznej inteligencji. Choć Nvidia nadal zachowuje dominację dzięki wszechstronnym układom GPU i szerokiemu wsparciu oprogramowania, to jednak przewagi TPU Ironwood w obsłudze inferencji stają się coraz bardziej widoczne — zwłaszcza dla projektów opartych o generatywne modele językowe, analitykę predykcyjną czy przetwarzanie w czasie rzeczywistym.

Przyszłość AI to nie tylko wyścig wydajności obliczeniowej, ale także batalia o szybkość odpowiedzi oraz minimalizację kosztów operacyjnych. Ironwood TPU wyznacza nowe trendy, a jego rozwój będzie w najbliższych latach uważnie obserwowany przez cały sektor IT, start-upy AI oraz największe korporacje świata. W tym kontekście inwestycje w dedykowane układy krzemowe będą kluczowe, a Google zyskuje silną pozycję jako innowator napędzający rozwój chmurowej sztucznej inteligencji.

Źródło: wccftech

Zostaw komentarz