14 Minuty

Cztery wiodące modele AI. Dziewięć kategorii zadań. Jeden ogólny zwycięzca. To nie laboratorium z niejasnymi rankingami – to praktyczne, kompleksowe porównanie zadań, które naprawdę mają znaczenie: rozwiązywanie realnych problemów pod presją czasu, generowanie obrazów i wideo, weryfikacja faktów offline, analiza trudnych danych, kreatywność na żądanie, naturalna komunikacja głosowa, a także pogłębiony research odporny na błędy. Każde zadanie ocenialiśmy w skali od 0 do 4, sumując wyniki, by na koniec wskazać lidera i – co równie ważne – przyporządkować każdy model do typu zadań, w których jest najlepszy.

Krótka odpowiedź: Gemini wygrywa z 46 punktami. Tuż za nim plasuje się ChatGPT z wynikiem 39, Grok zajmuje trzecie miejsce z 35, a DeepSeek kończy stawkę z 17. Nie oznacza to jednak, że zawsze warto wybierać zwycięzcę. Każda kategoria premiuje inne mocne strony, więc dobór modelu zależy od konkretnych zadań. W recenzji zobaczysz, gdzie każdy model bryluje, a gdzie ma trudności – na przykładach i z pełną transparentnością ocen.

Jak testowaliśmy modele?

Porównywane modele: ChatGPT, Gemini, Grok, DeepSeek.

Kategorie: dziewięć głównych, niektóre obejmują kilka tur lub poleceń.

Ocena: każda tura od 0 do 4 punktów. Gdy oryginalne zestawienie zawierało konkretne wyniki lub rankingi, zachowaliśmy je, w innych przypadkach kierowaliśmy się tymi samymi zasadami.

Ograniczenia: gdy runda nie pozwalała na dostęp do internetu, szanowaliśmy to. Jeśli funkcja była niedostępna (np. generowanie obrazów czy wideo dla DeepSeek), model zyskiwał zero punktów.

Szybkość: odnotowana opisowo, ale nie brana pod uwagę w punktacji, by zachować zgodność z oryginalnym konkursem.

Unikaliśmy sztucznych pułapek – skupiliśmy się na rzeczywistym zachowaniu modeli, także na typowych błędach, np. generowaniu nieistniejących obiektów w analizie obrazów czy powierzchownej matematyce budżetowej.

Kategoria 1: Rozwiązywanie problemów

Dwa realistyczne wyzwania, oceniane niezależnie, następnie sumowane.

Tura 1: Masz 10 dolarów, rozładowany telefon, brak mapy i 45 minut na dotarcie do dworca w obcym mieście – podaj 5-etapowy plan.

Szybkość: DeepSeek odpowiada w 7 sekund, Grok w 11, Gemini w 21, ChatGPT w 62.

Jakość: Wszystkie cztery opracowują użyteczne, strukturalne plany.

Ocena koleżeńska: Pokazaliśmy wszystkim modelom odpowiedzi i zapytaliśmy, która jest najlepsza. Każdy niezależnie wybrał ChatGPT.

Wyniki, tura 1

ChatGPT 4, Gemini 3, Grok 2, DeepSeek 1.

Tura 2: Po opłaceniu czynszu masz 400 dolarów na żywność, transport i internet. Żywność kosztuje 50 tygodniowo, transport 80 miesięcznie, internet 60 miesięcznie. Chcesz iść na wydarzenie za 200 dolarów w przyszłym miesiącu. Jak to zaplanować?

Prawdziwa pułapka. ChatGPT, Grok i DeepSeek proponują odłożenie tylko 60 dolarów teraz i „oszczędność później”, co jest błędem. Gemini jako jedyny od razu dostosowuje strategię: ogranicza wydatki na jedzenie o 15 dolarów tygodniowo dzięki promocjom i planowaniu posiłków, by zmniejszyć deficyt już w tym miesiącu.

Wyniki, tura 2

Gemini 4, ChatGPT 3, Grok 3, DeepSeek 2.

Podsumowanie rozwiązywania problemów

| Model | Tura 1 | Tura 2 | Razem |

|---|---|---|---|

| ChatGPT | 4 | 3 | 7 |

| Gemini | 3 | 4 | 7 |

| Grok | 2 | 3 | 5 |

| DeepSeek | 1 | 2 | 3 |

Wnioski: ChatGPT świetnie planuje krok po kroku i wygrywa głosowanie, ale Gemini lepiej dostosowuje się do nowych ograniczeń. Oba modele otrzymują ex-aequo najwyższą notę.

Kategoria 2: Generowanie obrazów

Dwa polecenia. DeepSeek nie obsługuje tej funkcji, więc z definicji ma zero.

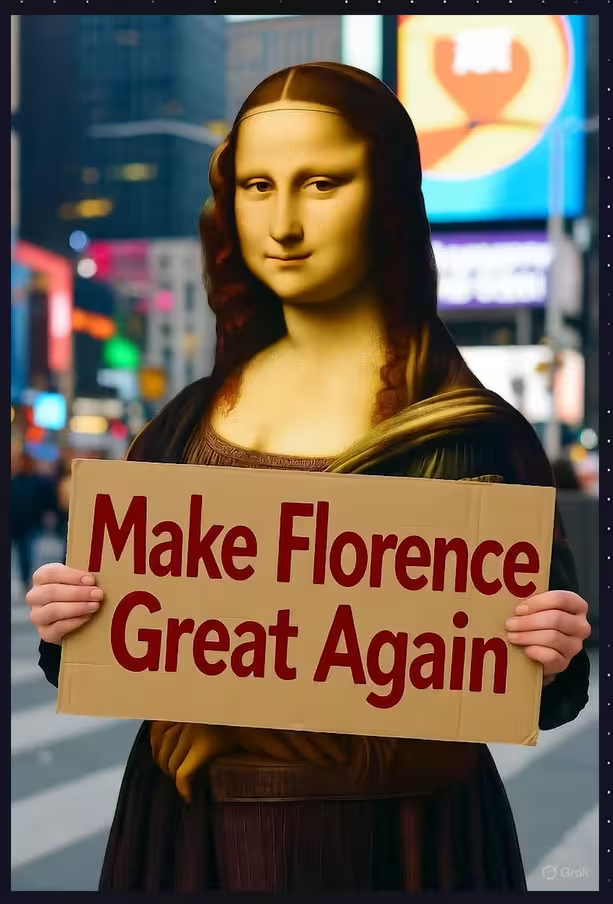

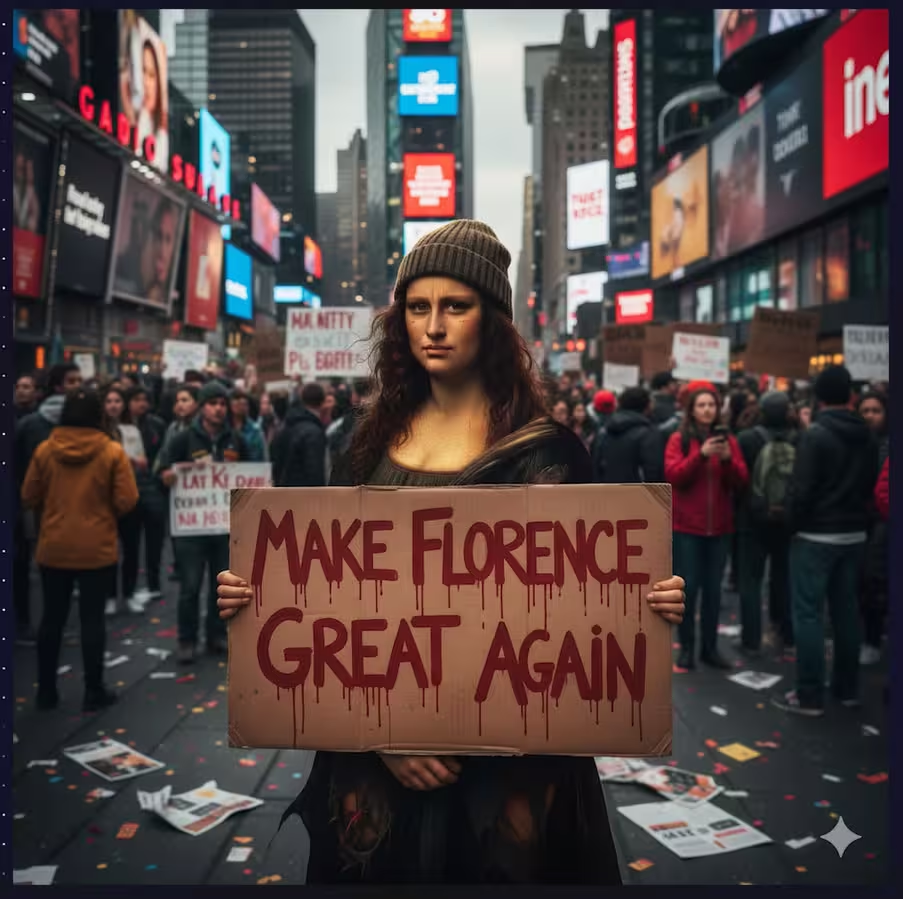

Polecenie 1: Fotorealistyczna Mona Lisa jako sfrustrowana protestująca na Times Square z kartonem „Make Florence great again” czerwonymi literami.

Grok: Najszybszy, ale sztuczny wygląd – postać z anatomicznymi błędami.

Gemini: Kompozycja i tło dobre, ale postać nadal ma trzy ręce.

ChatGPT: Najbardziej przekonująca postać, realne tło Times Square, napis spełnia wymagania.

Wyniki

ChatGPT 4, Gemini 3, Grok 1, DeepSeek 0.

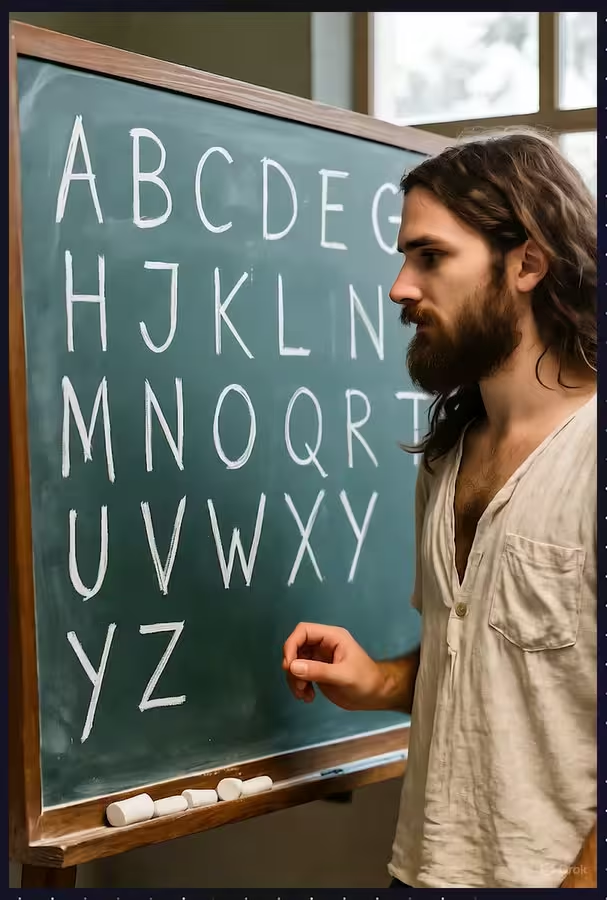

Polecenie 2: Fotorealistyczna klasa z nauczycielem-hipisem przy tablicy z całym alfabetem, litery coraz mniejsze.

Grok: Klasa i pismo autentyczne, ale alfabet niepełny.

Gemini: Bardziej stylizowany niż fotorealistyczny, litery niemal zbyt idealne.

ChatGPT: Najbardziej realistyczny całościowo – światło, detale klasy, wiarygodny nauczyciel; pismo aż zbyt idealne.

Konkurs ograniczył tu maksymalną notę do 3 punktów.

Wyniki

ChatGPT 3, Gemini 2, Grok 2, DeepSeek 0.

Podsumowanie generowania obrazów

| Model | P1 | P2 | Razem |

|---|---|---|---|

| ChatGPT | 4 | 3 | 7 |

| Gemini | 3 | 2 | 5 |

| Grok | 1 | 2 | 4 |

| DeepSeek | 0 | 0 | 0 |

Wnioski: ChatGPT to najbardziej rzetelny wybór do fotorealistycznych zadań. Gemini zazwyczaj zbliża się jakością, Grok ma trudności z anatomią i odczytywaniem tekstu.

Kategoria 3: Weryfikacja faktów offline

Trzy pytania jednokrotnego wyboru. Poziom pewności notowany, ale nie wpływał na ocenę.

Pytanie 1: Ile kurczaków zabito na mięso w 2018 roku?

Opcje: 690 mln, 6,9 mld, 69 mld, 690 mld.

Prawidłowa odpowiedź: 69 miliardów.

Grok trafia od razu.

ChatGPT podaje zakres obejmujący poprawną wartość.

Gemini i DeepSeek podają ok. 65 miliardów.

Wyniki

Grok 4, ChatGPT 3, Gemini 1, DeepSeek 1.

Pytanie 2: Jakie roczne dochody w 2020 plasowały w globalnym top 1%?

Opcje: 200 tys., 75 tys., 35 tys., 15 tys.

Prawidłowa: 35 tys..

Gemini podaje 34 tys.

ChatGPT 200 tys., Grok 60 tys., DeepSeek 75–85 tys.

Wyniki

Gemini 4, pozostali 0.

Pytanie 3: Jaki był udział energii z paliw kopalnych w USA w 2019?

Opcje: 83%, 63%, 43%, 23%.

Prawidłowa: 63%.

Gemini podaje dokładnie 63%.

ChatGPT 63–65%, Grok 62%, DeepSeek 60–65%.

Wyniki

Gemini 4, ChatGPT 3, Grok 3, DeepSeek 3.

Podsumowanie weryfikacji faktów

| Model | P1 | P2 | P3 | Razem |

|---|---|---|---|---|

| ChatGPT | 3 | 0 | 3 | 6 |

| Gemini | 1 | 4 | 4 | 9 |

| Grok | 4 | 0 | 3 | 7 |

| DeepSeek | 1 | 0 | 3 | 4 |

Wnioski: Gemini wygrywa precyzją i powtarzalnością. Grok trafia w pierwszym pytaniu, ale mija się z prawidłową granicą dochodu. Zakresy ChatGPT pomagają, lecz liczy się dokładność.

Kategoria 4: Analiza multimodalna

Dwie tury: zdjęcie lodówki oraz scena „Gdzie jest Waldo?”.

Tura 1: Co jest w lodówce? Zaproponuj 3 dania z dostępnych składników.

DeepSeek nie rozpoznaje przedmiotów – brak oceny.

ChatGPT pomija 3 produkty, ale nie wymyśla dodatkowych, potrawy odpowiadają faktycznej zawartości.

Gemini przeocza 7 rzeczy i wymyśla cytrusy, których nie ma.

Grok pomija 3 produkty, tworzy też długą listę nieistniejących.

Wyniki

ChatGPT 4, Gemini 3, Grok 2, DeepSeek 0.

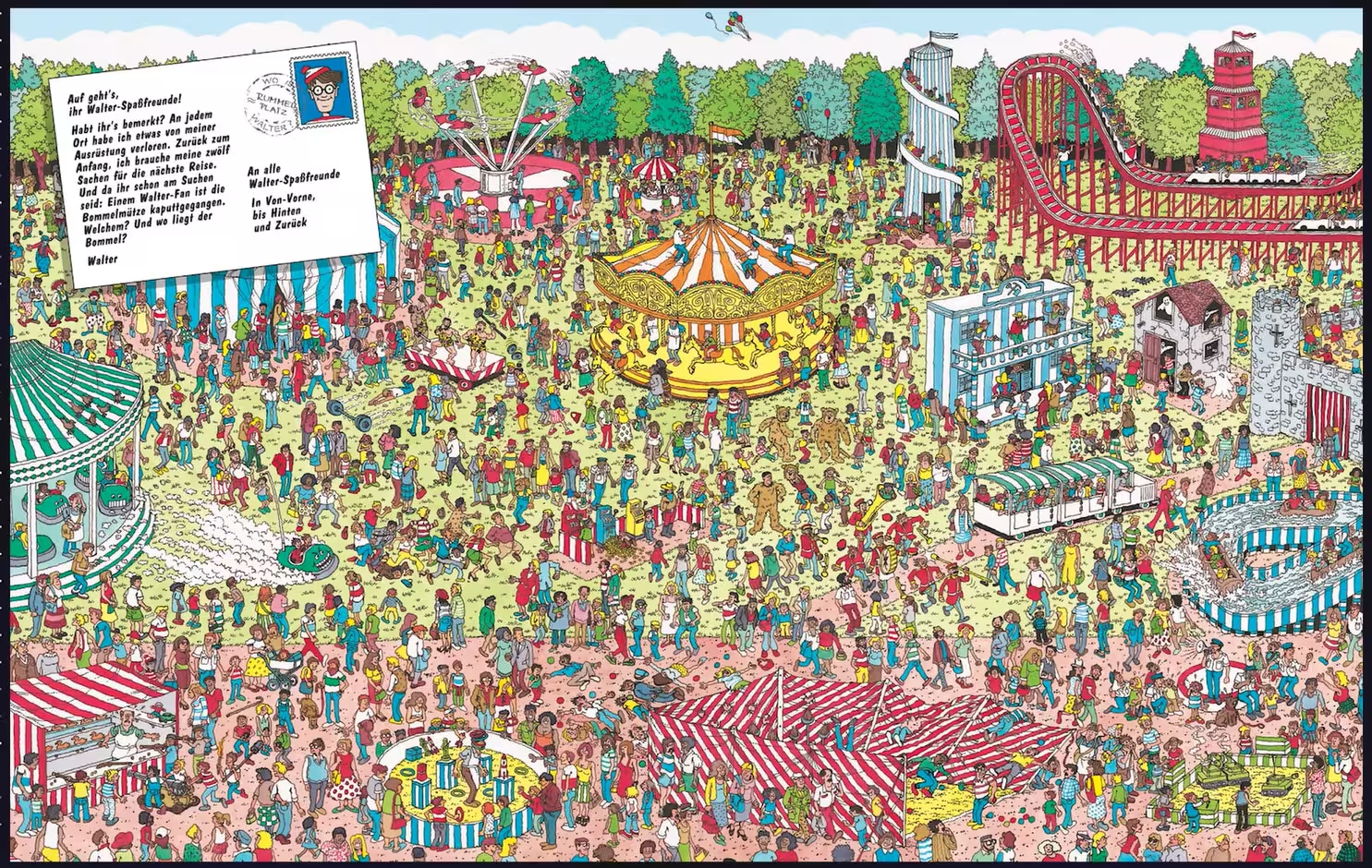

Tura 2: Znajdź Waldo w gęstej ilustracji.

Żaden model nie odnalazł Waldo. DeepSeek czyta losowy tekst i nie udziela odpowiedzi.

Wyniki

Wszystkie 0.

Podsumowanie analizy multimodalnej

| Model | Lodówka | Waldo | Razem |

|---|---|---|---|

| ChatGPT | 4 | 0 | 4 |

| Gemini | 3 | 0 | 3 |

| Grok | 2 | 0 | 2 |

| DeepSeek | 0 | 0 | 0 |

Wnioski: generowanie nieistniejących przedmiotów obniża przydatność praktyczną. ChatGPT powstrzymuje się przed halucynacjami i wygrywa rundę.

Kategoria 5: Generowanie wideo

Dwie klasyczne sceny. DeepSeek nie generuje wideo – zero punktów.

Tura 1: Animacja na podstawie kultowego zdjęcia Neila Armstronga na Księżycu

Sora 2 odmówił animacji ludzi, więc użyliśmy tekstowego opisu. Dźwięk zaskakująco mocny.

Gemini: Najbardziej filmowe wrażenia i świetna synchronizacja dźwięku. Błąd fizyczny: powiewająca flaga.

Grok: Ogólnie poprawnie, lecz skala nieekonomiczna, pojawia się wiatr.

ChatGPT: Przeciętnie, mniej porywająco niż u konkurentów.

Wyniki

Gemini 4, Grok 3, ChatGPT 2, DeepSeek 0.

Tura 2: Robotnicy na stalowych dźwigarach nad miastem

Gemini: Najlepszy ruch kamery i parallax; papierosy lekko nierealistyczne.

Grok: Dobrze oddane napięcie; gazety ulegają nienaturalnym zmianom mid-scena.

ChatGPT: Poprawnie, ale nie wyróżnia się.

Wyniki

Gemini 4, Grok 3, ChatGPT 2, DeepSeek 0.

Podsumowanie generowania wideo

| Model | Tura 1 | Tura 2 | Razem |

|---|---|---|---|

| Gemini | 4 | 4 | 8 |

| Grok | 3 | 3 | 6 |

| ChatGPT | 2 | 2 | 4 |

| DeepSeek | 0 | 0 | 0 |

Wnioski: Gemini wygrywa jakością ruchu i dźwiękiem. Grok blisko, choć popełnia błędy realizmu. ChatGPT daje przewidywalność, lecz mniej filmowy efekt.

Kategoria 6: Generowanie kreatywne

Dwa polecenia – żarty i gry słów.

Polecenie 1: Trzy oryginalne gry słów z wyjaśnieniem.

Wszystkie modele spełniają wymagania. Ulubienie zespołu:

„Chciałem zrobić żart o USB, ale nie przyjął się.”

Wyniki

ChatGPT 3, Gemini 3, Grok 3, DeepSeek 3.

Polecenie 2: Trzy oryginalne żarty – rozbaw mnie do łez

Grok tworzy głównie żarty o smartfonach i Wi-Fi – nie spełnia polecenia ogólnego.

ChatGPT, Gemini, DeepSeek dostarczają typowe „tacie żarty”. Hit:

„Piekarnia mojego kolegi spłonęła w nocy. Jego biznes to dziś tost.”

Wyniki

ChatGPT 4, Gemini 4, DeepSeek 4, Grok 1.

Podsumowanie kreatywności

| Model | Gry słów | Dowcipy | Razem |

|---|---|---|---|

| ChatGPT | 3 | 4 | 7 |

| Gemini | 3 | 4 | 7 |

| DeepSeek | 3 | 4 | 7 |

| Grok | 3 | 1 | 4 |

Wnioski: trójstronny remis na czele. DeepSeek wypada znakomicie w lekkim, szybkim dowcipie.

Kategoria 7: Tryb głosowy

Trzy urządzenia w minidebacie. DeepSeek nie posiada trybu głosowego – zero punktów.

ChatGPT – początkowo dziwne pauzy i zmiany tonu.

Gemini – płynna, naturalna melodia, rytm stały.

Grok – szybki, pewny siebie, z odrobiną „pikanterii”. W rywalizacji głosowej z Gemini remis.

Wyniki

Gemini 4, Grok 4, ChatGPT 2, DeepSeek 0.

Wnioski: dla naturalnych rozmów głosowych obecnie najlepiej sprawdzają się Gemini i Grok.

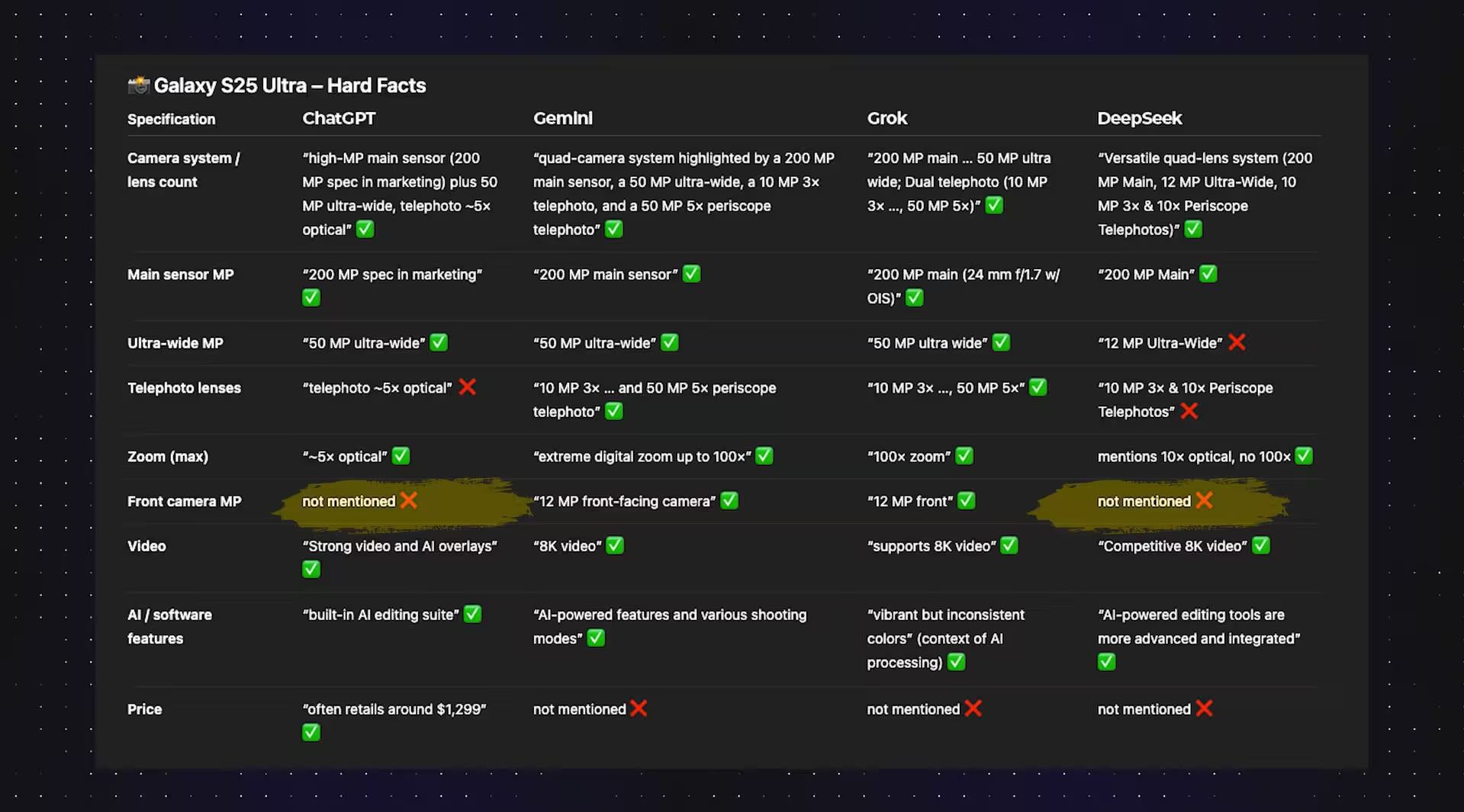

Kategoria 8: Zaawansowany research

Zadanie: porównaj iPhone 17 Pro Max vs Galaxy S25 Ultra pod kątem fotografii, korzystając z recenzji i oficjalnych danych. Który lepszy, w skrócie.

DeepSeek błędnie przypisuje 5x zoom iPhone’owi (to 4x), zaniża Galaxy ultra-wide do 12 Mpix zamiast 50, powołuje się na teleobiektyw 10x (już nieobecny).

ChatGPT pomija podwójny zoom Galaxy i przednie kamery, ale uwzględnia cenę.

Gemini poprawnie wymienia kamery Galaxy, dostarcza zbalansowaną konkluzję.

Grok najpełniej i najdokładniej omawia specyfikację.

Wszyscy uznają verdict: iPhone lepszy pod względem spójności i jakości wideo, Galaxy króluje w zoomie i możliwościach AI – zgodnie z doświadczeniem branżowym. Wciąż warto potwierdzać detale specyfikacji.

Wyniki

Grok 4, Gemini 3, ChatGPT 2, DeepSeek 1.

Wnioski: Grok wygrywa w researchu, Gemini tuż za nim, ChatGPT pomocny, lecz pomija kluczowe cechy, DeepSeek wymaga więcej precyzji.

Kategoria 9: Szybkość (obserwacje, brak punktacji)

ChatGPT – najszybszy w zwykłym tekście, zwalnia przy obrazach i researchu.

Gemini – stabilny niemal wszędzie, rzadko skrajnie szybki lub wolny.

Grok – przeważnie szybki, bywa wolniejszy w analizie i researchu.

DeepSeek – bardzo szybkie odpowiedzi, nawet poniżej 10 sekund, ale często kosztem kontekstu i dokładności.

Szybkość nie była oceniana punktowo, by zachować zgodność sum punktowych z oryginałem.

Pełna tabela wyników

Dla pełnej transparentności – tabela sumaryczna zgodna z oficjalnym konkursem.

| Kategoria | ChatGPT | Gemini | Grok | DeepSeek |

|---|---|---|---|---|

| Rozwiązywanie problemów | 7 | 7 | 5 | 3 |

| Generowanie obrazów | 7 | 5 | 4 | 0 |

| Weryfikacja faktów | 6 | 9 | 7 | 4 |

| Analiza | 4 | 3 | 2 | 0 |

| Generowanie wideo | 4 | 8 | 6 | 0 |

| Kreatywność | 7 | 7 | 4 | 7 |

| Tryb głosowy | 2 | 4 | 4 | 0 |

| Research | 2 | 3 | 4 | 1 |

| Suma | 39 | 46 | 35 | 17 |

Ogólny zwycięzca: Gemini (46 pkt).

Drugie miejsce: ChatGPT (39), trzecie: Grok (35), czwarte: DeepSeek (17).

Mocne i słabe strony oraz typowe błędy modeli AI

Prawdziwa wartość porównań leży w zrozumieniu dlaczego modele zachowują się określony sposób. Oto powtarzające się obserwacje.

ChatGPT

Mocne strony: doskonałe rozumowanie pod presją, zachowawcza analiza obrazów (mniej „halucynacji”), świetne generowanie fotorealizmu, przewidywalna kreatywność.

Słabości: spowalnia przy ciężkich zadaniach multimodalnych, czasem braki w researchu, potrzeba lepszej naturalności mowy w trybie głosowym.

Błędy: niewielkie, ale istotne luki w odpowiedziach porównawczych; zbyt ogólne odpowiedzi przy skrótowych poleceniach.

Kiedy warto wybrać ChatGPT? Jeśli zależy Ci na generowaniu obrazów zgodnie z opisem, logicznym planowaniu krok po kroku lub przewidywalnej kreatywności. Sprawdzi się też przy przepisach i analizie dostępnych składników.

Gemini

Mocne strony: najlepszy balans ogólny; skuteczny fact-checking offline; przekonujące video i dźwięk; planująca problem-solving; najbardziej naturalny głos.

Słabości: czasem zbyt wypolerowane obrazy; zdarza się dodanie zmyślonych detali wizualnych; rzadko najszybszy.

Błędy: fotorealistyczne polecenia wymagające typografii lub precyzji anatomicznej mogą sprawić trudność; trzeba określić ograniczenia fizyczne (np. w wideo).

Kiedy warto wybrać Gemini? Kiedy potrzebujesz uniwersalnego modelu AI, łączącego analizę z multimodalnością, dbającego o poprawność i spójność wyników.

Grok

Mocne strony: świetny do pogłębionych badań, wyrazista osobowość głosu, szybkie pierwsze wersje, dobra struktura dyskusji.

Słabości: halucynacje obrazowe, błędy realizmu w wideo, czasem ślepe podążanie za jednym tematem w kreatywnych zadaniach.

Błędy: zmyślone przedmioty w analizie, pozorna pewność przy błędach, brak reakcji na zmianę polecenia.

Kiedy warto wybrać Grok? Jeśli potrzebujesz asystenta do agregowania danych i recenzji lub dynamicznej obecności głosowej. Przy precyzji warto ręcznie potwierdzić fakty.

DeepSeek

Mocne strony: szybkie odpowiedzi tekstowe, dobre żarty i krótkie formy kreatywne, radzi sobie z prostymi poleceniami kreatywnymi.

Słabości: brak generowania obrazów/wideo, nie rozpoznaje obiektów, słabsza precyzja przy researchu.

Błędy: przekonujące, lecz błędne liczby; czyta tekst z obrazu ignorując kontekst wizualny.

Kiedy warto wybrać DeepSeek? Jeśli liczy się prędkość i prostota oraz koszt – do szybkich draftów, żartów i zadań niewymagających głębokiej analizy.

Praktyczne rekomendacje według zastosowań

Fotorealizm w generowaniu obrazów, wierność poleceniu: ChatGPT

Analiza obrazów bez halucynacji: ChatGPT

Generowanie wideo (ruch, dźwięk): Gemini

Weryfikacja faktów offline: Gemini

Rozwiązywanie problemów pod presją: Gemini i ChatGPT

Naturalne rozmowy głosowe: Gemini i Grok

Porównania, zestawienia specyfikacji produktów: Grok

Szybki, lekki tekst kreatywny: DeepSeek

Dlaczego zwycięzca to nie zawsze najlepszy wybór?

Gemini wygrał dzięki połączeniu dokładności, elastyczności i jakości multimodalnej. To daje mu palmę pierwszeństwa. Ale na co dzień najważniejsze jest dopasowanie modelu do zadania. Jeśli pracujesz głównie na obrazach, ChatGPT może przewyższać oczekiwania rankingu. Do podsumowań specyfikacji Grok daje najszybsze wersje do publikacji. Do szybkich, prostych tekstów DeepSeek to funkcjonalny wybór.

Pomyśl o modelach AI jak o obiektywach fotograficznych – najlepszy nie zawsze jest odpowiedni do każdego zadania. Wybierz „ogniskową”, która odpowiada Twoim potrzebom.

Ograniczenia i powtarzalność testów

Brak internetu: Wszystkie modele działały na wbudowanej wiedzy, która się starzeje. Po kilku miesiącach testy mogą dać inne wyniki.

Losowość generatywna: Przy różnych uruchomieniach mogą się zmieniać drobne szczegóły lub sformułowania. W ocenach skupialiśmy się na poprawności treści, nie stylistyce.

Szybkość: Notowana opisowo – wydajność zależy od obciążenia infrastruktury i warunków, co może się zmieniać.

Braki modalne: Gdy model nie oferuje funkcji (np. DeepSeek bez obrazów/wideo), zero to nie minus za tekst, a po prostu odzwierciedlenie zakresu usługi.

Werdykt: ranking sztucznej inteligencji 2025

Zwycięzca: Gemini (46 pkt) – najlepszy uniwersalnie w 2025 roku. Świetny w weryfikacji faktów, generowaniu wideo, adaptacyjnym rozwiązywaniu problemów i naturalnym głosie.

Wicemistrz: ChatGPT (39 pkt) – lider fotorealizmu obrazów, mistrz planowania, pewny partner kreatywny, najostrożniejszy w analizie obrazów.

Trzecie miejsce: Grok (35 pkt) – lider researchu z charakterystyczną osobowością. Przy kluczowych danych wymaga weryfikacji.

Czwarte miejsce: DeepSeek (17 pkt) – prosty, szybki i zaskakująco zabawny przy lekkiej kreatywności, ale bez bogactwa multimodalności konkurentów.

Jeśli szukasz uniwersalnego modelu AI do codziennych zadań bez niespodzianek – sięgnij po Gemini. Jeśli cenisz generowanie obrazów i logiczne planowanie, ChatGPT będzie optymalnym wyborem. Do porównań specyfikacji i błyskotliwych debat głosowych postaw na Grok. Gdy liczy się taniość i szybkość prostych tekstów, DeepSeek spełni oczekiwania.

Dziewięć kategorii. Jedna tabela wyników. Mnóstwo niuansów. Z dobrym wyborem każdy z tych modeli AI może stać się najbardziej wartościowym partnerem w pracy.

Zostaw komentarz