4 Minuty

iOS 26 otrzyma potężne wsparcie AI dzięki Model Context Protocol

W kodzie pierwszej wersji deweloperskiej iOS 26.1 odkryto, że Apple przygotowuje natywną obsługę Model Context Protocol (MCP). Po wdrożeniu MCP umożliwi narzędziom AI spoza ekosystemu Apple głębszą integrację z aplikacjami na iPhone, iPad i Mac, pozwalając na realizację nowych, zaawansowanych zadań w aplikacjach.

Czym jest MCP i dlaczego to ważne

Model Context Protocol to uniwersalny protokół, który pozwala systemom sztucznej inteligencji żądać i przetwarzać dane kontekstowe bez potrzeby tworzenia indywidualnych integracji dla każdego źródła danych. MCP, początkowo opracowane przez Anthropic, zdobyło już uznanie wśród największych graczy AI, takich jak OpenAI i Google. Wersja deweloperska iOS 26.1 sugeruje, że Apple szykuje się do wsparcia tego standardu.

App Intents, Siri i protokół MCP

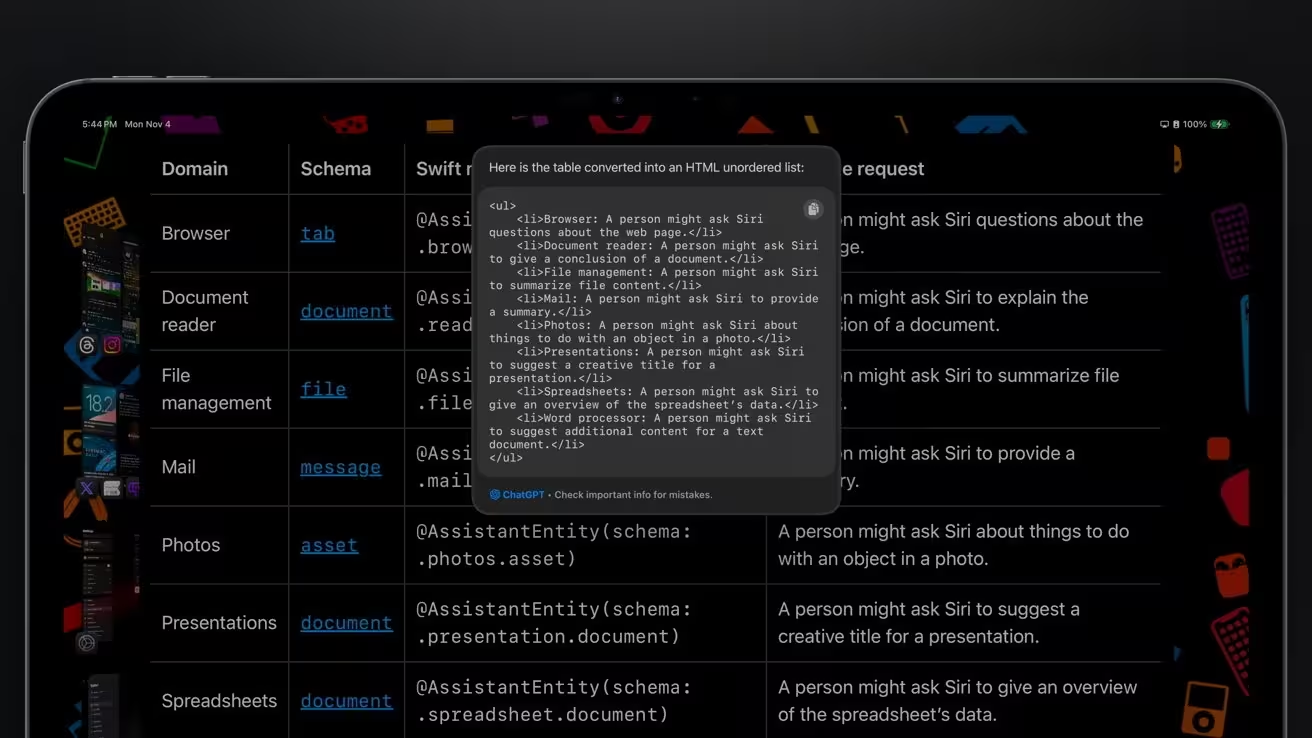

Framework App Intents od Apple już teraz umożliwia Siri i aplikacji Skróty wywoływanie działań wewnątrz aplikacji. Ostatnie usprawnienia App Intents — ściśle powiązane z Apple Intelligence — pozwoliły deweloperom udostępniać zawartość ekranu do analizy przez Siri. W praktyce oznacza to, że każda widoczna na ekranie treść może być przesłana systemowi AI w celu jej interpretacji.

Dzięki obsłudze MCP, usługi AI firm trzecich mogłyby korzystać z tych samych ścieżek integracji, by wchodzić w interakcję z aplikacjami. W przyszłości Siri będzie mogła odpowiadać na szczegółowe pytania dotyczące treści wyświetlanych na ekranie, edytować i udostępniać zdjęcia, dodawać adnotacje do postów w social media lub kompletować koszyk zakupowy bez konieczności ręcznej obsługi. Także użytkownicy będą mogli zlecić modelowi AI, takim jak ChatGPT od OpenAI, wykonanie tych czynności na wszystkich urządzeniach Apple.

MCP może również umożliwić asystentom AI kompleksowe zbieranie informacji z internetu. Najnowsze doniesienia wskazują, że Apple planuje powierzyć swoim modelom bazowym zadania związane z danymi osobowymi obsługiwanymi lokalnie, natomiast do pobierania i podsumowywania danych z sieci będzie wykorzystywać zewnętrzne modele AI — właśnie za pośrednictwem standaryzowanego przesyłania danych kontekstowych MCP.

Plany Apple na nową Siri

Pogłoski z września 2025 roku sugerują, że Apple wdroży funkcję wyszukiwania internetowego napędzaną modelami Apple Foundation, z opcjonalnym wsparciem Google Gemini dla pełniejszych podsumowań treści z sieci. Nowa Siri ma opierać się na trzech kluczowych modułach: planowaniu, operatorze wyszukiwania i podsumowywaniu. W założeniu własny model Apple odpowiadałby za planowanie i operacje wyszukiwania lokalnie na urządzeniu, podczas gdy wsparcie zewnętrznych modeli AI zapewniałoby pobieranie i podsumowywanie informacji z internetu.

Jeśli MCP stanie się częścią iOS, modele zewnętrzne takie jak Google Gemini mogłyby nie tylko prezentować wyniki wyszukiwania, lecz także samodzielnie wykonywać operacje w aplikacjach innych firm. Apple zapowiadało wcześniej rozszerzenie możliwości Siri w tym zakresie, jednak wdrożenie zostało opóźnione. Pozwolenie AI firm trzecich na realizację takich zadań mogłoby być rozwiązaniem pośrednim, dając użytkownikom większą elastyczność.

Jednocześnie MCP umożliwi Siri samodzielny dostęp do sieci i wykorzystanie zgromadzonych informacji bez polegania wyłącznie na zewnętrznych źródłach. Wdrożenie standardowego protokołu udostępniania kontekstu otworzy drogę zarówno modelom Apple, jak i asystentom AI innych firm do sprawnego pobierania i wykorzystywania kluczowych danych.

Obecnie Siri umożliwia już bezpieczne wyszukiwanie internetowe z poszanowaniem prywatności użytkownika, a bardziej zaawansowane zadania przekazuje usługom takim jak ChatGPT — zawsze za zgodą użytkownika. Strategia Apple polega na współpracy z firmami AI zamiast budowania zamkniętego ekosystemu. Takie otwarte podejście może znacząco przyspieszyć rozwój funkcji SI i zaoferować użytkownikom bogatszy wybór rozwiązań.

Premiera nowej Siri spodziewana jest na początek 2026 roku jako element aktualizacji iOS 26.x.

Źródło: appleinsider

Zostaw komentarz