3 Minuty

Globalna premiera dubbingu głosowego opartego na AI od Meta

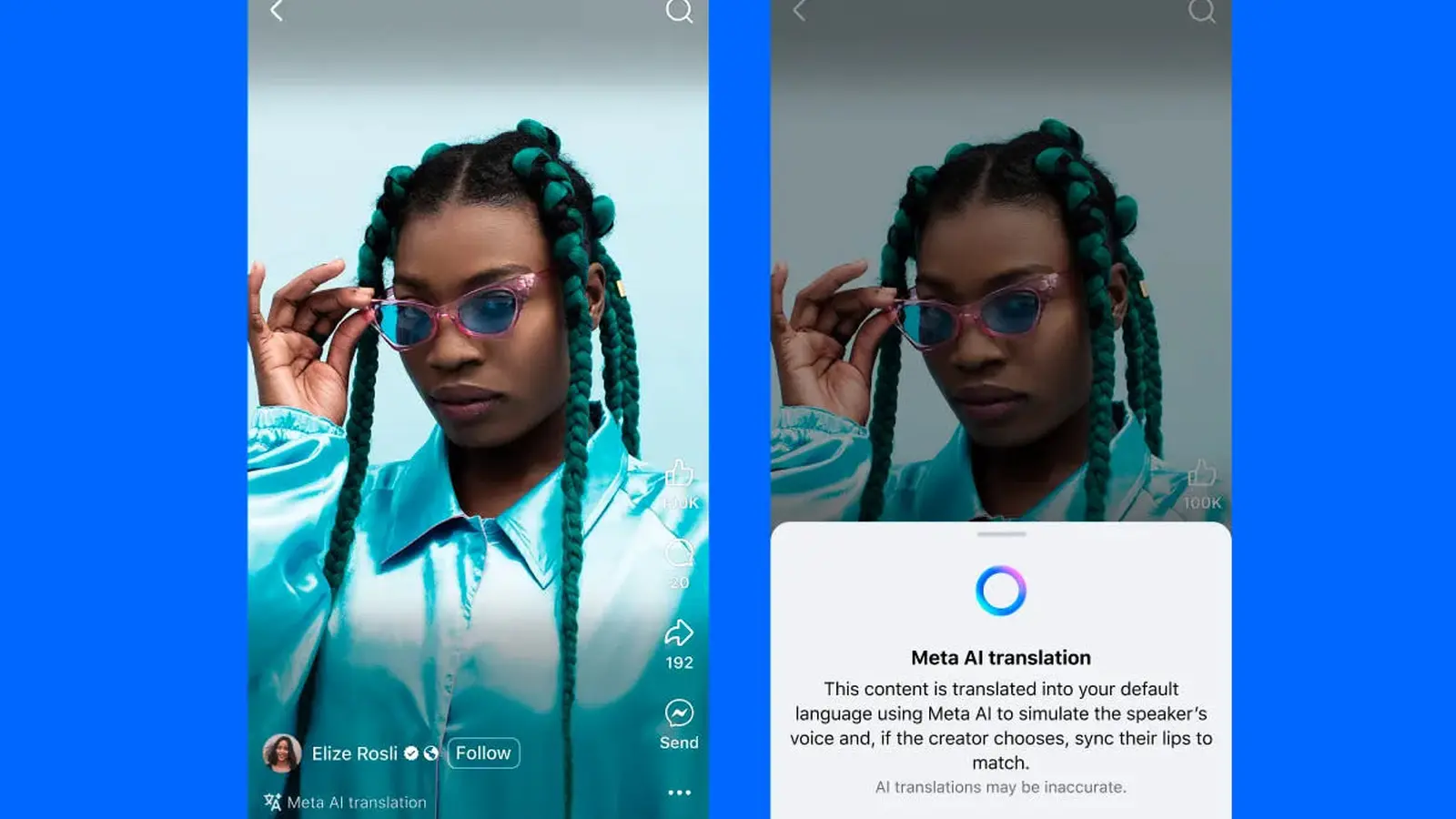

Meta rozpoczęła ogólnoświatowe wdrażanie swojej innowacyjnej funkcji automatycznego dubbingu głosowego, wykorzystującej sztuczną inteligencję, dla filmików Reels. Pierwsze informacje o tym narzędziu pojawiły się podczas Meta Connect 2024, gdy Mark Zuckerberg zaprezentował możliwości rozwiązania. Technologia generatywnej AI tłumaczy na żywo mowę twórcy na inny język, z opcjonalnym zsynchronizowaniem ruchu ust z dostosowanym dźwiękiem w nowej wersji językowej.

Główne cechy produktu

Tłumaczenie i klonowanie głosu

Nowa opcja opiera się na analizie oryginalnego głosu użytkownika, aby stworzyć przetłumaczoną ścieżkę audio zachowującą charakterystyczny ton oraz rytm mowy twórcy. W momencie startu dostępne są tylko tłumaczenia z angielskiego na hiszpański i odwrotnie, jednak firma zapowiada rozszerzenie obsługi innych języków w kolejnych aktualizacjach.

Dopasowanie ruchu ust i podgląd tłumaczenia

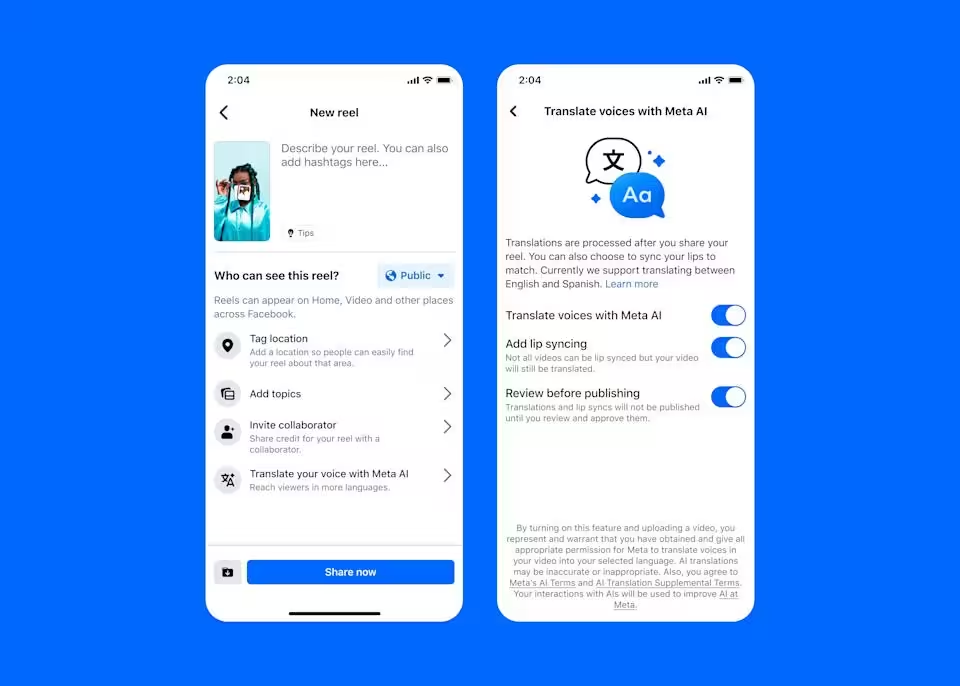

Twórcy mają możliwość włączania lub wyłączania synchronizacji ust oraz sprawdzenia podglądu wygenerowanego tłumaczenia zanim treść zostanie opublikowana. Opcja podglądu oraz synchronizacji ust jest dostępna przed finalnym udostępnieniem materiału. (Meta)

Dostępność i warunki korzystania dla twórców

Początkowo funkcja dostępna jest dla twórców publikujących na Facebooku i posiadających minimum 1 000 obserwujących, natomiast każdy użytkownik z publicznym kontem na Instagramie może użyć tego narzędzia. Aby z niej skorzystać, przy publikacji Reels należy wybrać opcję "Przetłumacz swój głos z Meta AI" — w tym samym menu znajduje się przełącznik synchronizacji ust oraz możliwość wstępnego odsłuchu. Odbiorcy zobaczą czytelną informację na ekranie, że klip został przetłumaczony przez AI.

Zasady korzystania i wskazówki techniczne

Meta rekomenduje, aby uzyskać najlepsze efekty, nagrywać filmy z twarzą zwróconą bezpośrednio do kamery. Zalecane jest również, by nie zasłaniać ust oraz unikać intensywnej muzyki w tle. System obsługuje maksymalnie dwóch mówców, przy czym najlepsze rezultaty daje, gdy wypowiedzi nie nakładają się na siebie. Takie wymagania pozwalają AI dokładnie i naturalnie zsynchronizować głos i wizualizację w tłumaczeniu.

Znaczenie nowej funkcji — korzyści i miejsce na rynku

Dla marek oraz twórców treści, szybkie tłumaczenie głosu na inne języki i opcja lip-sync umożliwiają ekspansję na nowe grupy odbiorców bez barier językowych, usprawniając lokalizację i zwiększając widoczność materiałów. Meta wprowadziła też narzędzie statystyk, pozwalające sprawdzić skuteczność treści według języka, analizować zaangażowanie oraz konwersję — to cenne wsparcie w globalnej strategii rozwoju treści i analityce marketingowej.

Konkurencja i pozycjonowanie na rynku

Wejście Meta na rynek zaawansowanych tłumaczeń AI to odpowiedź na działania innych gigantów: YouTube już w zeszłym roku wdrożyło podobną funkcję, a Apple zintegrowało tłumaczenie na żywo z aplikacjami Wiadomości, Telefon oraz FaceTime w iOS 16, 17 i 18 (wspominany iOS 26 potwierdza ogólnosektorowy trend). Meta wyróżnia się połączeniem klonowania głosu, generatywnego tłumaczenia sztuczną inteligencją oraz opcjonalnego dopasowania ust, celując szczególnie w krótkie formaty Reels.

Zastosowania

- Influencerzy planujący wejść na rynki hiszpańsko- i anglojęzyczne.

- Marki pragnące lokalizować kampanie wideo szybko, bez potrzeby ponownego nagrania.

- Edukatorzy i mikro-wydawcy mogący prezentować krótkie lekcje w nowych językach i dla różnych publiczności.

Perspektywy rozwoju

Wraz z rozbudową obsługi językowej i ulepszaniem wsparcia dla większej liczby mówców, funkcja AI Meta może stać się rynkowym standardem w globalnej lokalizacji treści oraz SEO wideo w mediach społecznościowych. Na razie twórcom zaleca się testowanie funkcji przy użyciu wyraźnego dźwięku i niezasłoniętej twarzy dla osiągnięcia najlepszych rezultatów.

Źródło: engadget

Zostaw komentarz