3 Minuty

Przegląd: Głośna premiera przesłonięta niedociągnięciami wizualnymi

Najświeższy model od OpenAI, GPT-5, już działa i obsługuje ChatGPT, jednak wydarzeniu premierowemu towarzyszył niespodziewany zgrzyt — prezentowane ilustracje i wygenerowane obrazy nie wytrzymały podstawowej analizy. Zamiast wyznaczać kolejny etap w kierunku AGI, wydarzenie przyciągnęło uwagę z powodu nieścisłych wykresów wydajności oraz błędów w generowaniu grafiki, co wywołało pytania o niezawodność modelu i standardy jego oceny.

Co poszło nie tak podczas demonstracji

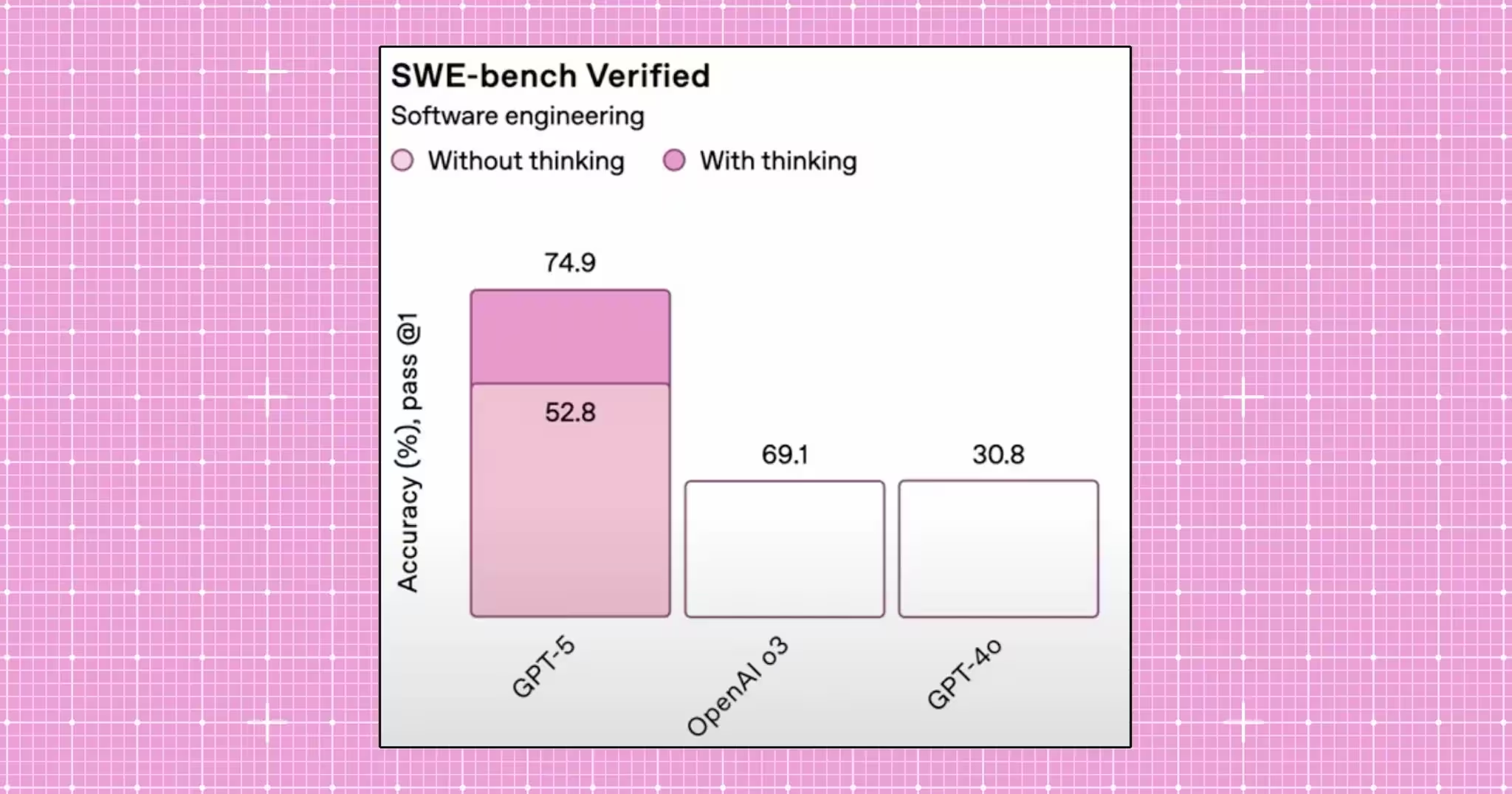

Najbardziej rzucającym się w oczy błędem był wykres słupkowy pokazujący wyniki testów kodowania w kolejnych generacjach modeli. Słup dla GPT-5, z wynikiem 52,8%, był niemal dwa razy wyższy niż dla starszego modelu o3, który uzyskał 69,1%. Co więcej, słupki dla wyników 69,1% i 30,8% (GPT-4o) pokazano na wykresie jako równie wysokie. Media społecznościowe i portale branżowe szybko wytknęły te nieścisłości, a fragmenty z wadliwym wykresem nadal można znaleźć w archiwum transmisji, mimo że na blogu poprawiono grafikę.

Reakcja CEO i natychmiastowe poprawki

Sam Altman skomentował viralową wpadkę żartobliwym wpisem o "mega wtopie na wykresie", a OpenAI dokonało korekty ilustracji na swoim blogu. Nie ujawniono jednak, czy za błędne wykresy odpowiadał człowiek, czy wygenerowało je automatyczne narzędzie.

Funkcje i możliwości produktu

GPT-5 wprowadza spodziewane udoskonalenia charakterystyczne dla nowych dużych modeli językowych: większe okna kontekstowe, lepszą obsługę danych multimodalnych oraz bardziej dopracowane generowanie kodu. Model promowany jest jako narzędzie do lepszego rozumienia języka naturalnego, skuteczniejszej integracji obrazu z tekstem oraz szybszych odpowiedzi w zastosowaniach produkcyjnych. Jednak demonstracja ujawniła, że model nadal ma problemy z grafiką i diagramami oraz skłonności do tzw. halucynacji.

Porównania i ocena wydajności

Według dokumentacji GPT-5 ma przewyższać GPT-4o i wcześniejsze modele, ale pokaz na żywo pokazał, jak ważna jest przejrzysta prezentacja i rzetelne testy. Czytelne, odtwarzalne benchmarki i jawna metodologia są kluczowe przy porównywaniu wydajności modeli, zwłaszcza gdy różnice mogą rzutować na wybory firm i środowisk naukowych.

Zalety i ograniczenia

- Zalety: mocniejsza integracja multimodalna, możliwość rozumienia dłuższych tekstów i rozbudowane narzędzia dla deweloperów do wdrażania AI w aplikacjach.

- Ograniczenia: Przykłady pokazują, że generowane obrazy i diagramy nadal zawierają przypadkowe opisy (np. mapy z nieistniejącymi nazwami miejsc), a część badań wskazuje, że nowocześniejsze modele rozumowania mogą być bardziej podatne na halucynacje w określonych warunkach.

Zastosowania i praktyczne znaczenie

Atuty GPT-5 mogą przysłużyć się rozwojowi AI konwersacyjnej, wsparciu w kodowaniu, generowaniu treści czy pracy z wiedzą przedsiębiorstw. Przykłady użycia to m.in. automatyzacja obsługi klienta, asystent recenzji kodu, podsumowania badań czy multimodalna kreacja treści. Niemniej, w sektorach regulowanych i w zadaniach krytycznych pod względem bezpieczeństwa, wciąż konieczna jest ścisła kontrola ludzka oraz rozbudowane procedury walidacyjne wobec skali halucynacji i błędów wizualnych.

Wpływ na rynek i zaufanie

Ta wpadka to nie tylko problem wizerunkowy — dla dostawców AI kluczowe jest zaufanie. OpenAI, działając na tak wysokiej wycenie i w tej skali, odczuwa skutki każdej prezentacji: od negocjacji z klientami, poprzez decyzje deweloperów, aż po opinię publiczną. Incydent ponownie rozbudza dyskusję o jakości danych uczących, precyzji dopasowania modelu oraz o tym, czy tylko zwiększanie skali gwarantuje lepsze rezultaty, a może rodzi nowe zagrożenia błędami.

Podsumowanie: Wnioski dla zespołów AI

Premiera GPT-5 pokazuje, że nawet liderzy rynku AI powinni stawiać na solidną walidację, jawność badań porównawczych i ostrożne wdrażanie innowacji. Praktycy mogą wynieść z tego lekcję: warto wdrażać rygorystyczną ewaluację, zapewniać kontrolę człowieka przy generowaniu obrazów i wrażliwych treści oraz wymagać dokładniejszej dokumentacji metryk i metod przy zestawianiu dużych modeli językowych.

Źródło: futurism

Zostaw komentarz